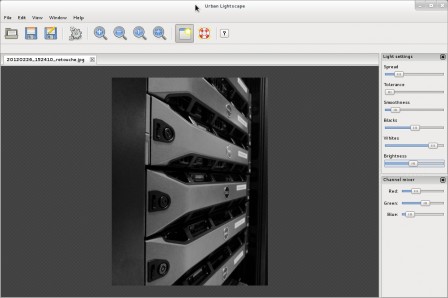

Slobberbone : Urban Lightscape : Un logiciel de retouche de photo dédié au traitement de la lumière

samedi 13 avril 2013 à 14:30Présentation

Parfois on tombe sur des outils très simples certes, mais aussi très efficaces ! C'est le cas d'Urban Lightscape ! Issu de mon Shaarli : http://www.slobberbone.net/shaarli/?searchtags=editor

Son travail jouer sur les effets de lumière. Point bar ! Si vous voulez faire d'autres choses, il faut aller voir du coté de pinta, gimp ou encore photofiltre lx.

Je vous propose de l'installer sous Fedora avec intégration dans GNOME !

Prérequis

# yum install wxGTK-devel boost-devel

Téléchargement :

Se rendre ici : http://www.indii.org/software/urbanlightscape/download ou

$ wget http://www.indii.org/files/urbanlightscape/releases/urbanlightscape-latest.tar.gz

Compilation

$ tar xvfz urbanlightscape-1.2.3.tar.gz

$ cd urbanlightscape-1.2.3/

$ ./configure --disable-assert CXXFLAGS="-O3 -g3"

$ make

$ cd ..

$ mv urbanlightscape-1.2.3/ /opt/

# chown -Rf user:user /opt/urbanlightscape*

Votre logiciel est compilé et placé dans /opt/ un répertoire pour ces logiciels n'ayant pas de rpm pour les installé là où il faut  !

!

Intégration Gnome Shell

Nous allons créer le fichier urbanlightscape.desktop dans /usr/share/appplications/ et y copier ce qui suit.

# vi /usr/share/applications/urbanlightscape.desktop

[Desktop Entry]

Version=1.2.3

Type=Application

Name=Urban Lightscape

GenericName=Image Light Editor

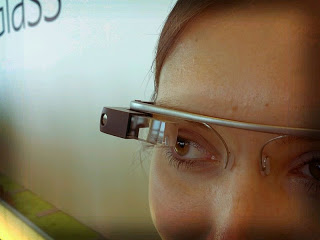

Comment=For photographers who love light

Exec=/opt/urbanlightscape-1.2.3/urbanlightscape

Icon=urbanlightscape

Terminal=false

Categories=Graphics;2DGraphics;RasterGraphics;GTK;

StartupNotify=false

MimeType=image/bmp;image/g3fax;image/gif;image/x-fits;image/x-pcx;image/x-portable-anymap;image/x-portable-bitmap;image/x-portable-graymap;image/x-portable-pixmap;image/tiff;image/jpeg;image/x-psp;image/png;image/x-icon;image/x-xpixmap;image/x-wmf;image/jp2;image/jpeg2000;image/jpx;image/x-xcursor;

Une fois fais, il reste à placer une icône issue du site :

# cd /usr/share/icons/

# wget http://www.indii.org/images/urbanlightscape_48.png

# mv urbanlightscape_48.png urbanlightscape.png

Et voilà, le tour est joué !

Original post of Slobberbone.Votez pour ce billet sur Planet Libre.

Articles similaires

- Slobberbone : gSharkDown - un client GTK du site de musique en ligne GrooveShark (29/10/2012)

- Paquet Fedora du Jour : Divertissement du Vendredi: GnuBG - Backgammon, un jeu qu'il est bien ! (04/03/2011)

- Slobberbone : Migration Fedora 15 à Fedora 16 via preupgrade (30/11/2011)

- Slobberbone : Note : Installation VMware-Converter Fedora x86_64 (26/10/2012)

- Paquet Fedora du Jour : La GUI du Jeudi : Hamster - Une interface de suivi du temps (11/04/2013)