La Smart City policière se répand comme traînée de poudre

jeudi 5 juillet 2018 à 10:41En mars, nous levions un bout du voile qui entoure encore le projet orwellien de la « Smart City™ » marseillaise. Mais force est de constater que le cas de Marseille n'est que l'arbre qui cache la forêt. Car la police prédictive et les centres de surveillance policière dopés aux Big Data pullulent désormais sur le territoire français. Une dérive qu'illustre très bien le cas de Nice : la ville de Christian Estrosi, grand obsédé sécuritaire, a fait appel à Engie Inéo et Thalès, par ailleurs concurrents sur ce marché en plein essor, pour deux projets censés faire advenir la « Safe City™ » niçoise. Or, face à cette fuite en avant dans les technologies de contrôle social que nos élus assument sans rougir, la présidente de la CNIL semble trouver qu'il urgent de... suivre la situation. Ce qui revient à laisser faire.

Cet hiver, Christian Estrosi, maire de Nice, a encore fait parler de lui. Il paradait, tout fier du contrat passé avec une entreprise israëlienne pour permettre, via une application smartphone, aux citoyens de se faire auxiliaires de police. Sollicitée par le conseil municipal de la ville, la CNIL a fait savoir fin mars son opposition, pointant le manque de base légale du dispositif ainsi que l'atteinte « disproportionnée » au droit à la vie privée qui en résultait.

Mais cette controverse relayée dans les médias a masqué l'essentiel. Car depuis l'an dernier, Nice aussi se prépare à devenir la Smart City™ du turfu en misant sur des partenariats avec de grandes entreprises des technologies de contrôle. Et on ne parle pas d'une petite boîte israélienne. On parle de Thales, bien connue, ou d'Engie-Inéo, une filiale Big Data du groupe Engie (Suez) (dans lesquelles l'État français détient respectivement 26,4% et 32,76% de parts). On ne parle pas non plus d'une simple « app » permettant de faire entrer le vigilantisme et la délation à l'ère 3.0, non. On parle de centres de contrôle-commande équipés de tout l'attirail moderne pour sonder quantités de bases de données issues des services publics ou d'entreprises privées, surveiller en temps réel l'espace public urbain et ce qui se dit sur les réseaux sociaux, faire de la police « prédictive »...

À Nice, première expérimentation d'Engie Inéo

D'une part, il y a le projet d'Engie Inéo, une expérimentation annoncée à l'été 2017 (on devait être à la plage, on était en tout cas passé à côté), qui aurait pris fin en février 2018. L'an dernier la mairie présentait le projet en ces termes :

ENGIE Ineo expérimentera à Nice une solution globale de sécurité inédite : un centre de contrôle et de commandement basé sur une table tactile et tactique « DECIDE » et la plateforme SenCity.

Le développement progressif de ce dispositif a pour but de mettre à disposition, notamment des autorités policières, une plateforme tactique et tactile pour assurer une coordination globale en temps réel.

(...) En s’appuyant sur les ressources locales et sur l’ensemble des données collectées par la métaplateforme SenCity, (caméras, bornes escamotables, feux de circulation, boutons d’alerte, contrôles d’accès des bâtiments) ce dispositif révolutionne les solutions de sécurité mises à disposition des décideurs.

C'est du « totalement inédit », à en croire Thierry Orosco, Directeur des Stratégies de Sécurité d’Engie Inéo. Ça ressemble à s'y méprendre à ce qui se trame à Marseille, et dont nous soulignions les dangers il y a quelques semaines. Cette « révolution » marque en tout cas une nouvelle étape dans la privatisation des forces de sécurité, alors que ces outils techniques sont appelés à jouer un rôle central non seulement dans la préemption et la répression policières, mais aussi plus largement dans le « management » des forces de l'ordre. C'est d'ailleurs le premier syndicat de la police municipale qui l'écrit, en réaction à l'affaire Reporty : « Il n'est jamais bon, sur le plan moral, de déléguer le service public de la sécurité à des personnes privées ».

La team Thales dans la roue

Quant à Thales, elle semble reprendre le flambeau à la tête d'un consortium qui propose une nouvelle « expérimentation ». Le mois dernier, le conseil municipal de Nice votait en effet une convention d'expérimentation « Safe City », en dépit des critiques d'une partie de l'opposition.

Thales a aussi jeté son dévolu sur le quartier de La Défense en région parisienne. Le groupe se targue de son expérience dans le domaine de la sécurité et du numérique. Non, il ne s'agit pas de la Plateforme nationale des informations judiciaire des interceptions (PNIJ) (qui, pour le coup, est un fiasco total, très coûteux). Il s'agit de « vidéosurveillance intelligente ».

La vidéosurveillance devient « smart »

C'est la grande mode. Après avoir dépensé des centaines de millions d'euros pour des caméras aux résultats insignifiants, les industriels ne jurent désormais que par l'analyse automatique des images. Le ministre de l'Intérieur, Gérard Collomb, s'en faisait le VRP encore récemment, alors qu'il dissertait le 8 juin dernier sur la répression des mouvements sociaux (il parlait des ZAD et des manifestations). Et le ministère amer d'indiquer :

En matière d’exploitation des images et d’identification des personnes, on a encore une grande marge de progression. L’intelligence artificielle doit permettre, par exemple, de repérer dans la foule des individus au comportement bizarre1.

On imagine, demain, ce que donnera l'utilisation de la reconnaissance faciale en lien avec des fichiers biométriques comme le fichier TES dans ces nouveaux dispositifs répressifs. Ce n'est pas céder à la facilité que de dire qu'en la matière, la Chine montre le chemin.

Vers un « Waze de la sécurité »

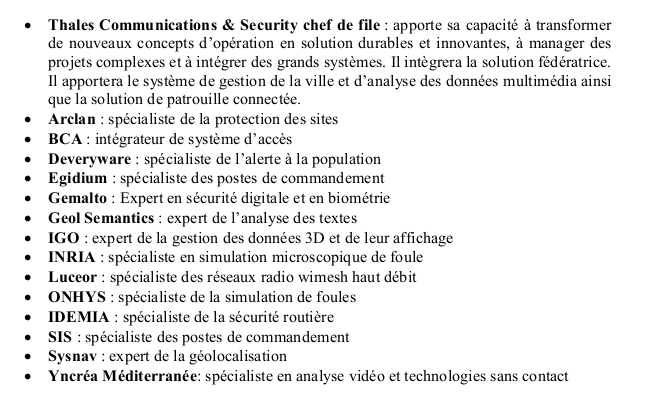

Dans un nouveau Projet d'expérimentation Safe City », Thales et le consortium qu'il dirige veulent aller plus loin, en créant le « Waze de la sécurité » à la sauce Big Data. Pour aider les « décideurs », il s'agit de « collecter le maximum de données existantes et d'en chercher les corrélations et les signaux faibles » (p. 23), de « développer les nouveaux algorithmes d’analyse et de corrélation permettant de mieux comprendre une situation et de développer des capacités prédictives » (p. 24). Comme à Marseille, la surveillance des réseaux sociaux et autres « données ouvertes » sont en ligne de mire, notamment pour les « textes courts et mal écrits » chers à Twitter qui passeront à la moulinette d'outils d'analyse sémantique pour aider à la gestion des foules, à l'analyse des rumeurs, et le « suivi des actions de certains individus ou groupes de personnes » (là, le spécialiste du consortium est l'entreprise GEOLSemantics).

Certes, pour l'heure, tout cela relève aussi et surtout d'un discours marketing destiné à appâter des élus en mal de sensationnel. Dans l'immédiat, ces projets sont bien des expérimentations, avec des « cas d'usage » relativement délimités. Ils permettent en fait à ces grands groupes de faire financer par l'État et les collectivités françaises, avec l'aide de l'Europe2 ou de la Banque publique d'investissement3, leur recherche et développement, et de disposer de « démonstrateurs » grandeur nature pour alimenter leurs campagnes de marketing sécuritaire.

Smart City policière, realpolitik industrielle ?

Pour ces grands groupes français et leurs émanations institutionnelles telles que le CoFIS (le comité de la filière industrielle de sécurité, organisé au niveau du ministère de l'Intérieur), il s'agit en effet de se positionner dans le marché en plein essor de la Smart City™, alors que les grandes multinationales américaines comme Google ou chinoises comme Huawei sont en embuscade.

Tout cela va évidemment bien au-delà du champ de la sécurité. Dans le viseur, l'ensemble des services publics sont concernés, des transports à l'énergie en passant par la gestion des déchets. Sur tous ces sujets, des entreprises comme Thalès ou Engie Inéo espèrent pousser les ville à faire exploser leurs budgets. Et Pierre Cunéo, en charge de la Stratégie, recherche et technologie chez Tales, de regretter que « pour l'instant pas une ville ne demande de tout mettre en réseau (...). Tout cela ne concerne que la sécurité. Les budgets des villes ne permettent pas encore d'aller plus loin ». Là aussi, ces projets d'expérimentation ont valeur de test pour des stratégies de séduction des agents, et convertir ainsi les services publics à leurs « solutions » et les rendant toujours plus dépendants de l'expertise privée. Avec à la clé pléthore de juteux contrats publics.

Mais revenons-en à la police. Si, aux États-Unis, les incursions de plus en plus marquées des GAFAM dans le complexe militaro-industriel suscitent des oppositions en interne4, on n'attend pas forcément grand-chose de la part des employés de grandes boîtes associées depuis longtemps aux politiques sécuritaires (mais si on se trompe, des lanceurs d'alerte peuvent nous écrire ou répondre à l'appel de Mediapart !).

À Nice, autour du projet de Big Data policier, Estrosi appelle ainsi à « faire vivre un éco-contexte favorable à l’innovation en renforçant ses collaborations avec de grands groupes industriels, des PME et des start-up locales, notamment liées au réseau de la French Tech, ainsi qu’avec le monde de la recherche et de l’enseignement ». De fait, les acteurs qui participent au développement et à la banalisation de ces outils de surveillance sont nombreux. Côté recherche, l'origine et la structure des financements et les rapprochements marqués des champs sécuritaires et universitaires sont un véritable problème qui devrait interroger (plusieurs des solutions proposées à Nice par le consortium de Thales sont issues des projets de recherche de la Commission européenne ou de l'Agence nationale de la recherche). Quant à la French Tech, peut-être voudra-t-elle bien, dans un futur pas trop lointain, faire connaître sa volonté de ne pas devenir « pigeon des espions » ? Ou pas.

La CNIL attentiste

Dans le Sud-Est, on est habitué aux délires sécuritaires. Mais ne vous y trompez pas : tout le monde risque d'y passer dans un futur proche. À Toulouse, à Valenciennes, à Paris, à Dijon, des initiatives similaires sont achevées ou en cours. La vague de la Smart City policière déferle sur la France.

En janvier dernier, La Quadrature écrivait à la CNIL pour demander un rendez-vous et discuter de l'action du gendarme de la vie privée dans ces dossiers, et notamment du cas marseillais. Les travaux du comité de prospective de la CNIL l'an dernier5, de même que la « jurisprudence » Reporty qui pointait l'absence de base légale, laissaient augurer d'une opposition claire à l'ensemble de ces projets. Après plusieurs demandes et relances, nous avons finalement reçu un courrier fin juin, qui a pour le moins douché nos espoirs. Isabelle Falque Pierrotin, présidente de la CNIL, nous y écrit :

La CNIL entend se montrer particulièrement vigilante quant au développement de dispositifs de ce type qui, à l'évidence, sont susceptibles d'engendrer des risques élevés pour les droits et libertés des individus. (...) J'ai adressé au maire de Marseille un courrier soulignant l'impérieuse nécessité de tenir compte du nouveau cadre juridique relatif à la protection des données personnelles, tel qu'issu de la Directive (UE) 2016/680 et du Règlement (UE) 2016/679 du Parlement européen et du Conseil.

S’agissant d'un projet visant à exploiter à grande échelle des données potentiellement identifiantes et à la sensibilité particulière (infractions, santé, situation sociale, localisation, opinions, etc.), au moyen d'un outil technologique innovant axé sur une mécanique de combinaison d'informations issues de sources diverses et collectées à des fins différentes, intégrant également des activités de surveillance, d'évaluation et de prédiction, j'ai tout particulièrement attiré son attention sur l'obligation lui incombant de procéder à une analyse de l'impact du traitement projeté sur la vie privée et les libertés des personnes concernées.

La Commission suivra attentivement la façon dont la Ville a apprécié la pertinence et la proportionnalité des données et opérations auxquels elle envisage de recourir, comme la compatibilité des finalités de réutilisation de ces informations avec celles ayant présidé à leur collecte. Elle s'attachera également à contrôler que l'exploitation de celles-ci, dans les conditions projetées, ne se heurte pas à des dispositions légales encadrant leur traitement et si les intérêts légitimes des individus ont été suffisamment pris en compte. Enfin, elle sera très attentive aux mesures d'encadrement techniques et organisationnelles, prises par la ville pour garantir aux informations un niveau de sécurité approprié.

« Vigilance », « analyse d'impact », « suivi attentif ». Autant le diagnostic technique est juste, autant la réponse esquissée s'apparente à un inquiétant laisser-faire. Pour nous, en jugeant sur la base des documents obtenus, il est évident qu'en l'absence d'un cadre législatif ad hoc, et comme le soulignait la CNIL elle-même dans l'affaire Reporty6, ces dispositifs sont illégaux. À l'heure où tout le monde se gausse de l'entrée en vigueur des nouveaux textes européens sur la vie privée, il est pour le moins surprenant de voir ces nouvelles techniques fondamentalement contraires aux grands principes qui fondent ce texte s'imposer au cœur de nos villes .

Quant aux études d'impact sur la vie privée que la CNIL appelle de ses vœux, les projets en cours ne l'envisagent pas (ou alors en des termes très vagues). Si elles sont finalement menées, tout porte à croire que ce sont les prestataires retenus qui seront priés de les réaliser à l'issue de ces coûteuses expérimentations... Cette posture attentiste de la CNIL permet juste de temporiser, le temps que Ministère de l'Intérieur nous sorte un projet de loi sur la « police 3.0 » chère à Gérard Collomb, pour venir légaliser tout cela7.

Bref, si l'on veut éviter d'être une nouvelle fois mis devant le fait accompli (comme en 2015 avec la loi renseignement), ce n'est pas la vigilance qu'il nous faut, c'est un moratoire sur l'ensemble de ces projets de Smart City policière. Et des gens qui, sur le terrain, puissent tenir en échec ces technocratie obsédée par le contrôle social.

- 1. Source : La Croix

- 2. Dans le projet marseillais, 500 000 euros viennent des fonds FEDER consacré à la cohésion des territoires européens (voir PDF).

- 3. La BPI finance le projet d'expérimentation à Nice, à en croire la délibération du Conseil municipal.

- 4. Voir par exemple les cas de Google ou d'Amazon

- 5. “Smart City et Données Personnelles : Quels Enjeux de Politiques Publiques et de Vie Privée ?”, CNIL, Octobre 2017. https://www.cnil.fr/sites/default/files/atoms/files/cnil_cahiers_ip5.pdf.

- 6. En mars, la CNIL estimait ainsi : « Au regard des risques élevés de surveillance des personnes et d’atteinte à la vie privée qui pourraient résulter d’un usage non maîtrisé d’un tel dispositif, la CNIL a donc estimé qu’il était hautement souhaitable qu’un tel dispositif fasse l’objet d’un encadrement législatif spécifique ; par ailleurs elle a conclu que la proportionnalité du dispositif REPORTY n’était en l’état pas garantie ».

- 7. Pour le ministre, la « police 3.0 » renvoie à « la vision que nous devons avoir d’une police et d’une gendarmerie qui doivent sans cesse savoir prendre le virage des évolutions technologiques et d’un monde en réseaux » (source). Voir aussi : Gerric Poncet, « Gérard Collomb : "À délinquance numérique, police numérique" ». Le Point, Février 2018. http://www.lepoint.fr/politique/gerard-collomb-a-delinquance-numerique-police-numerique-08-02-2018-2193250_20.php.

| Fichier attaché | Taille |

|---|---|

| courrier_CNIL_marseille_anon.pdf | 143.88 Ko |

| Convention_expérimentation_SafeCity_Nice.pdf | 2.52 Mo |

| Deliberation14091.pdf | 52.93 Ko |