10 ans de Creative Commons : réussites, limites et défis à relever

dimanche 16 décembre 2012 à 13:04[Hier avait lieu à la Gaîté Lyrique une journée pour célébrer les 10 ans des Creative Commons. J'ai eu le grand honneur d'y participer et je poste ici la chronique que j'avais rédigée à cette occasion pour OWNI, illustrée par des sites et des exemples d'utilisation des CC que j'ai découverts à cette occasion].

Les licences Creative Commons vont bientôt fêter les dix ans de leur création ! La fondation Creative Commons a en effet été lancée en 2001, à l’initiative notamment du juriste américain Lawrence Lessig, et les premiers jeux de licences ont été publiés en décembre 2002.

Avant de souffler les bougies, fermons les yeux et essayons d’imaginer un instant à quoi ressemblerait Internet si les licences Creative Commons n’existaient pas… Nul doute que quelque chose d’essentiel nous manquerait, car les CC sont devenus un des standards de l’environnement numérique.

Durant ces dix années, l’arsenal législatif, communautaire et international de protection de la propriété intellectuelle n’a cessé de se renforcer et de se rigidifier, même si les rejets d’ACTA et de SOPA ont marqué cette année un premier coup d’arrêt à ce mouvement. Dans le même temps, les Creative Commons ont pourtant apporté la preuve qu’il était possible de penser le droit d’auteur autrement, sans attendre que les lois soient modifiées.

Et c’est sans doute ce qu’il y a de plus spectaculaire avec les CC. S’appuyant sur des contrats, qui sont la base même du fonctionnement du droit d’auteur, les licences Creative Commons ont introduit dans la sphère de la création générale le renversement copernicien que les licences libres, type GNU-GPL, avaient déjà opéré dans le domaine du logiciel. Elles y ont ajouté l’idée géniale d’un signalétique simple et claire des droits en ligne, sous forme de logos et de résumés simplifiés, qui favorisent l’appropriation des licences par les non-juristes.

Créés en dehors de l’action des États, les Creative Commons ont permis de « hacker » de l’extérieur le droit d’auteur pour donner une base juridique aux pratiques de mise en partage des oeuvres, de production collaborative de contenus et de réutilisation créative (remix, mashup). Partir des libertés plutôt que des restrictions pour diffuser leurs oeuvres, voilà ce que les licences Creative Commons permettent aux auteurs, à partir d’un système d’options qui offrent à chacun la possibilité de choisir le degré d’ouverture convenant à son projet.

En cela, les Creative Commons ont pour but de remettre l’auteur au centre du système et si l’on en croit les chiffres avancés dans la brochure The Power of Open, ce sont plus de 400 millions d’oeuvres par le monde qui ont été ainsi mise en partage par leurs créateurs, formant une réserve conséquente de biens communs volontaires.

Les Creative Commons sont porteurs d’une révolution pour la conception du droit d’auteur et pour son adaptation aux exigences de l’environnement numérique. Michel Serres avait particulièrement bien expliqué les enjeux d’une telle évolution dans cette interview :

Dans une société, il y a des zones de droit et des zones de non-droit. La forêt était jadis une zone de non-droit infestée de malandrins et de voleurs. Un jour, pourtant, un voyageur traversant la forêt de Sherwood constata que tous les voleurs portaient une sorte d’uniforme ; ils portaient tous un chapeau vert et ils étaient sous le commandement de Robin Hood. Robin, qu’est-ce que ça veut dire ? Celui qui porte la robe du juge. Robin incarne le droit qui est en train de naître dans un lieu où il n’y avait pas de droit. Toutes les lois qu’on veut faire sur les droits d’auteur et la propriété sur Internet, c’est de la rigolade. Internet est un lieu de non-droit comme la forêt dont nous parlions. Or un droit qui existe dans un lieu de droit n’est jamais valable dans un lieu de non-droit. Il faut que dans ce lieu de non-droit émerge un nouveau droit. Dans le monde de demain doit émerger un nouveau droit. Si vous voulez réguler le monde d’aujourd’hui avec le vieux droit, vous allez échouer, exactement comme on a fait sur Internet. Il faut attendre que dans la forêt d’Internet on puisse inventer un droit nouveau sur ce lieu de non-droit. Plus généralement, dans cette crise qui fait entrevoir un nouveau monde, ce n’est pas le droit ancien qui va prévaloir.

Issus directement de la « forêt d’Internet », les Creative Commons constituent l’un des pans de ce droit nouveau dont le système a besoin pour retrouver la paix et l’équilibre. Avis à ceux qui cherchent « à réguler le monde d’aujourd’hui avec le vieux droit » !

Pour essayer de faire un bilan de l’avancement du projet Creative Commons à l’occasion de ces 10 ans, voici 10 points d’analyse : 3 réussites à souligner, 3 limites à dépasser, 3 défis à relever et un horizon à atteindre.

[Le superbe projet Kopfschlag : une simple page web blanche sous CC-BY où les internautes sont invités à dessiner, modifier, effacer et recommencer à créer une oeuvre graphique sans fin]

3 réussites à souligner :

1) L’épreuve du feu de la validité en justice

Les Creative Commons ne sont pas des « alternatives » au droit d’auteur, mais une façon de le faire fonctionner autrement, en jouant avec la logique contractuelle. L’un des défis majeurs pour les licences consistait à se faire accepter par les juridictions dans les divers pays du monde, alors même qu’elles étaient nées en dehors de l’action des États.

Pour l’instant, cette épreuve du feu de la validité a été surmontée avec succès chaque fois que les Creative Commons ont été au coeur d’un litige soumis à un juge. Les Creative Commons ont ainsi été reconnues valides en Espagne, en Allemagne, aux Pays-Bas, en Belgique, aux Etats-Unis, en Israël.

Aucune affaire cependant en France n’a encore porté sur une oeuvre placée sous licence Creative Commons, ce qui permet parfois à certains juristes de continuer à faire planer le doute sur leur compatibilité avec le droit français ou d’entretenir la confusion avec l’expression « libre de droits« . Au vu des décisions rendues par d’autres juridictions en Europe, il n’y a pourtant pas lieu de penser que les Creative Commons ne seraient pas valables au pays de Beaumarchais.

2) L’adoption par de grandes plateformes des médias sociaux

La semaine dernière, la plateforme de partage de photographies 500px annonçait qu’elle offrirait désormais à ses utilisateurs la possibilité d’utiliser les licences Creative Commons. Cette adoption par les médias sociaux a joué un rôle décisif dans la diffusion des licences.

Le fait que Flickr ait très tôt offert cette possibilité à ses utilisateurs a constitué un jalon important, qui fait actuellement de cette plateforme un des réservoirs les plus importants d’oeuvres sous CC (plus de 240 millions). D’autres sites importants comme Vimeo, Soundcloud ou Bandcamp ont suivi cet exemple. Le fait que la communauté de Wikipedia ait aussi choisi en 2009 de faire passer l’encyclopédie collaborative sous CC-BY-SA a également constituer un tournant essentiel. En 2011, c’est YouTube qui avait créé l’évènement en annonçant la mise en place de la possibilité de placer des vidéos sous CC. En moins d’un an, ce sont plus de 4 millions de fichiers qui ont été mis en partage par le biais des licences sur la plateforme de Google.

Cette inclusion progressive des licences Creative Commons dans l’écosystème des médias sociaux est incontestablement une réussite, mais elle rencontre certaines limites importantes. Des réseaux sociaux comme Facebook ou Twitter n’offrent toujours pas cette possibilité à leurs usagers (même si des applications non-officielles existent). En août dernier, il a fallu qu’un service tiers « force la main » à Instagram en utilisant son API pour que les utilisateurs de ce service puissent enfin placer leurs photos sous CC, avec des résultats mitigés.

Nul doute que l’articulation entre les Creative Commons et les CGU des grands médiaux sociaux constitue un point essentiel pour leur développement.

3) La mise en place de modèles économiques convaincants

L’un des arguments utilisés pour dénigrer les Creative Commons consiste à soutenir que les licences impliqueraient nécessairement une diffusion gratuite et qu’elles empêcheraient les artistes de tirer bénéfice de leurs créations. C’est grossièrement faux et les Creative Commons ont apporté la preuve qu’elles pouvaient être utilisées au contraire pour mettre en place des modèles économiques innovants.

Grâce aux clauses NC (Pas d’usage commercial), les créateurs peuvent moduler l’ouverture des licences et continuer à monétiser certains types d’usages tout en laissant circuler leurs oeuvres. Ces modèles mixtes ont produit de belles réussites dans tous les domaines, qu’il s’agisse de musique, de livres, de vidéo ou de jeux .

L’articulation entre Creative Commons et crowdfunding ouvre également des pistes très intéressantes aux artistes pour obtenir des financements tout en élargissant les droits de leur public. Une page spéciale du site américain Kickstarter liste les projets pour lesquels les auteurs ont proposé de placer leur création sous licence Creative Commons si le public les aidait à rassembler les financements en amont. On retrouve le même principe sur d’autres plateformes comme Indiegogo, ou côté français Ulule et KissKissBankBank, tandis que le site espagnol Goteo propose exclusivement le financement de projets sous licences libres.

Par bien des côtés, ces pratiques annoncent sans doute les modèles économiques de demain.

[My Science Work : réseau social destiné à sensibiliser les chercheurs pour développer l'Ope Access]

3 limites à dépasser :

1) Remédier à l’imprécision de la clause non-commerciale

A l’occasion du passage à la version 4.0, un débat assez vif a divisé la communauté Creative Commons à propos de l’opportunité de maintenir la clause Non-Commerciale parmi les options proposées par les licences.

Il est clair que l’imprécision relative de cette clause fragilise la mise en oeuvre des Creative Commons, d’autant plus que les licences NC sont les plus utilisées. Le juriste Benjamin Jean estime que Creative Commons International a une part de responsabilité dans ce flottement :

j’accuse pour ma part Creative Commons de maintenir ce flou en ne souhaitant pas faire le choix d’une définition précise (le problème d’une telle définition est 1) qu’il n’emporterait pas l’unanimité et 2) qu’elle ne saurait être rétroactive…).

Pour la version 4.0, il semblerait que Creative Commons ait choisi de s’en tenir au statu quo et de maintenir cette clause en l’état, vu qu’aucun consensus ne se dégageait nettement concernant sa reformulation. Il faudra sans doute pourtant réouvrir tôt ou tard cette réflexion, qui touche à quelque chose d’essentiel dans la capacité des licences Creative Commons à servir de base pour le développement de modèles économiques.

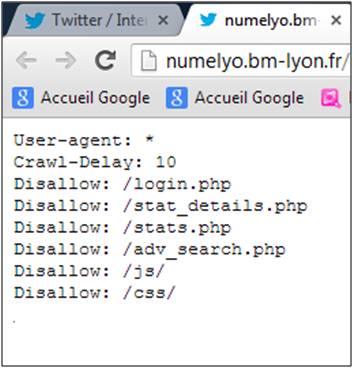

2) Une meilleure application aux bases de données et à l’Open Data

Une des évolutions que Creative Commons n’a pas très bien négocié ces dernières années est celle de l’Open Data. On aurait pu penser que ces licences auraient pu être employées pour ouvrir les bases de données et libérer les informations publiques, mais des difficultés juridiques sont survenues qui ont limité l’application des Creative Commons dans ce domaine.

Les licences Creative Commons sont prévues pour s’appliquer aux droits voisins, mais la version 3.0 appréhende relativement mal le droit sui generis des bases de données tel qu’il existe en Europe. Par ailleurs, les licences Creative Commons n’étaient pas non plus prévues pour encadrer le droit à la réutilisation des informations, ce qui a pu conduire à des flottements en France dans le cdare du développement de l’Open Data.

Certains pays ont néanmoins choisi d’opter pour les Creative Commons pour diffuser leurs données (Autriche, Australie, Nouvelle-Zélande), mais d’autres comme l’Angleterre ou la France ont préféré écrire leurs propres licences. Les difficultés susmentionnées ont aussi conduit certains gros projets collaboratifs, comme OpenStreetMap à changer de licence, préférant l’ODbL, spécialement conçue pour les bases de données aux licences Creative Commons.

Il avait été envisagé que la version 4.0 des CC soit modifiée pour mieux prendre en compte le droit des bases de données et c’est sans doute un enjeu important pour que Creative Commons continuer à jouer un rôle dans le domaine de l’Open Data.

3) Développer la compatibilité avec la gestion collective des droits :

Un des facteurs qui freinent fortement l’adoption des Creative Commons par les artistes réside dans le fait que les sociétés de gestion collective n’acceptent généralement pas que les auteurs placent tout ou partie de leur répertoire sous licence ouverte. Les artistes sont donc réduits à choisir entre utiliser les Creative Commons ou entrer en gestion collective.

Pour autant, reprenant une formule qui avait déjà été testée en 2007 aux Pays-bas, Creative Commons a conclu fin 2011 un partenariat avec la SACEM en France pour monter une expérience pilote, afin d’ouvrir aux auteurs et compositeurs de musique la possibilité d’utiliser certaines des licences CC.

On peut considérer qu’il s’agit d’une avancée importante pour la reconnaissance des Creative Commons en France, mais cet accord a également soulevé de nombreuses critiques, notamment de la part des communautés du Libre, ainsi qu’a propos de la façon dont la SACEM entend redéfinir la définition du Non-Commercial de manière extensive.

Il est clair pourtant qu’il est crucial que les sociétés de gestion collective s’ouvrent aux licences Creative Commons, mais le défi consiste à organiser cette connexion sans que les licences subissent des altérations qui en dénaturent la logique.

[Featurin.gs : une plateforme qui propose de partager des beats, des voix et des vidéos sous Creative Commons, pour créer ses propres remix en toute légalité]

3 défis à relever :

1) Une meilleure prises en compte par les mécanismes traditionnels de financement de la création

On peut s’étonner que les licences Creative Commons ne soient pas davantage utilisées dans le domaine du cinéma par exemple. Il existe des exemples dans le domaine du court métrage d’animation et le Film espagnol El Cosmonauta du producteur espagnol Riot Cinema avait constitué un exemple intéressant de combinaison du crowdfunding et des licences libres pour un projet ambitieux.

Mais il faut plutôt aller voir du côté des modes de financement et de distribution des oeuvres cinématographiques pour comprendre pourquoi il est très difficile pour des films sous CC de voir le jour. Le cinéma bénéficie en effet d’importantes subventions, comme les avances sur recettes du CFC. Or les oeuvres sous licences libres ne peuvent pas bénéficier de ces formes de financement, ce qui les coupent de leviers importants. C’est une situation qu’a souvent dénoncé le Collectif Kassandre en France, avant de décider de mettre fin à ses activités cette année.

Il est clair qu’un des moyens de favoriser le développement d’oeuvres sous licence Creative Commons seraient d’organiser des filières particulièrement de financement et de distribution, par les organismes de soutien à la création que sont par exemple le CNC pour le Cinéma ou le CNL pour les livres. Cela pourrait d’ailleurs constituer un des axes de réflexion de la Mission Lescure pour favoriser le développement de l’offre légale.

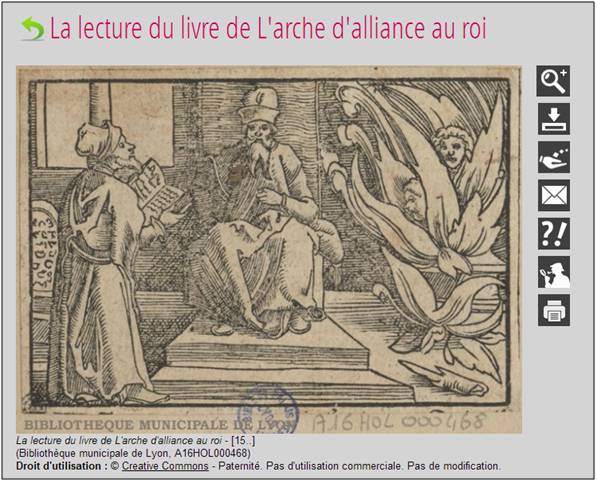

2) Favoriser l’adoption des licences Creative Commons par les administrations

L’adoption des licences Creative Commons par les administrations est un facteur qui peut grandement contribuer à leur diffusion. Pour l’instant, les exemples restent cependant relativement rares. Le site de la Maison blanche est par exemple placé sous licence CC-BY, mais il est assez difficile de citer d’autres cas aussi emblématiques. On assiste même parfois à des retours en arrière, comme au Brésil où le Ministère de la Culture a choisi en 2011 de retirer la licence Creative Commons de son site pour retourner à un régime de droits réservés.

Pourtant il existe un intérêt réel pour les administrations et les services publics à entrer dans la logique de mise en partage et de collaboration que favorisent les licences Creative Commons. En France, la municipalité de Brest par exemple montre comment ont peut développer une dynamique participative et l’expression citoyenne au niveau d’un territoire à partir de sites et de plateformes placées sous licence Creative Commons.

Au niveau central, on pourrait espérer que le premier ministre par exemple prolonge la circulaire qui a été récemment publiée pour favoriser l’usagedes logiciels libres dans les administrations par un texte incitant les services à placer les contenus qu’ils produisent sous licence Creative Commons. Une telle démarche d’Open Content viendrait compléter celle qui est initiée actuellement au niveau de l’État en matière d’Open Data.

Dans cette optique, l’un des champs privilégiés serait le développement de ressources pédagogiques sous licence Creative Commons, ainsi que la mise à dispositions des résultats de la recherche scientifiques. La Californie aux États-Unis et la Colombie britannique au Canada ont récemment voté des textes de loi pour favoriser le développement de bibliothèques numériques de manuels d’enseignement Open Source, sous licence CC-BY. Le réseau européen Communia a également publié une déclaration importante la semaine dernière pour appeler les responsables de l’Union a rendre obligatoire non seulement l’Open Access aux articles scientifiques financés par des fonds publics en Europée, mais aussi leur passage sous licence CC-BY.

3) Peut-on rendre les Creative Commons Mainstream ?

Le défi majeur à mes yeux pour les licences Creative Commons consiste à savoir comment on peut en favoriser plus largement l’adoption, en dehors même du cercle des adeptes de la Culture libre.

Dans une chronique précédente, j’avais relevé par exemple que les 240 millions de photographies sur Flickr sous licence Creative Commons ne représentent au final qu’un peu plus de 3% des contenus du site. On retrouve à peu près les mêmes proportions sur la plateforme de partage de vidéos Vimeo. Même si en valeur absolu, l’adoption des Creative Commons par 3% des créateurs suffit à produire des masses de contenus réutilisables importantes, il est clair que l’on ne modifie pas un système en profondeur avec des pourcentages de cet ordre.

Arrivé à ce résultat au bout de dix ans, il est désormais essentiel pour Creative Commons de réfléchir à la manière dont les licences pourraient devenir « mainstream ». Une des pistes seraient peut-être de creuser les partenariats avec les grands médias. La BBC par exemple en Angleterre a conduit des expériences de diffusion de programmes télévisés sous licence Creative Commons, ainsi que pour ses archives. La chaîne d’information Al Jazeera est quant à elle engagée dans un usage avancé de diffusion ouverte de ses contenus, au sein de son Creative Commons Repository. En Hollande, c’est l’équivalent de l’INA qui valorise une partie de ses contenus sous licence Creative Commons sur la plateforme Images For The Future. Et la télévision norvégienne a déjà libéré certains de ses contenus sous licence CC, mais pour des volumes limités.

En France, on peut peut-être citer les exemples que la plateforme Arte Creative ou celui du site de critiques de livres Non Fiction, mais il faut bien avouer que les Creative Commons sont encore très en retrait dans les médias traditionnels.

[WebSpotting : une émission de télévision sous Creative Commons, diffusée sur la TNT et sur Internet]

Un horizon à atteindre

Au bout de 10 ans, les Creative Commons ont fait leur preuve quant à leur capacité à organiser la circulation et la réutilisation des contenus en ligne, tout en apaisant les relations entre les auteurs et le public. Certaines propositions de réforme du droit d’auteur vont à présent plus loin, en suggérant de placer tous les contenus postés sur le web par défaut sous un régime autorisant la réutilisation à des fins non-commerciales des oeuvres.

Une telle proposition avait été appelée Copyright 2.0 par le juriste italien Marco Ricolfi et elle aurait abouti dans les faits à faire passer par défaut le web tout entier sous licence CC-BY-NC, sauf pour les créateurs à s’enregistrer pour revendiquer l’application d’un copyright classique pour leurs œuvres.

On retrouve quelque chose de ces propositions dans les programmes qui visent à faire consacrer la légalisation du partage non-marchand entre individus des oeuvres, qu’il s’agisse des Éléments pour la Réforme du droit d’auteur de la Quadrature du Net ou du programme du Parti Pirate.

Si de telles réformes venaient à être mises en oeuvre, c’est l’ensemble du système du droit d’auteur qui serait modifié dans la logique des Creative Commons. Le régime juridique de base d’Internet deviendrait grosso-modo la licence CC-BY-NC et les auteurs pourraient toujours choisir d’aller plus loin en employant des licences encore plus ouvertes (CC-BY, CC-BY-SA, etc).

Rendez-vous dans dix ans, pour voir si cet horizon a été atteint !

Classé dans:Alternatives : Copyleft et Culture Libre Tagged: Creative Commons, culture libre, licences libres