Lundi soir, François Gèze, directeur des Editions La Découverte et membre du comité scientifique du registre ReLIRE institué par l’arrêté du 18 mars 2013, a laissé sous le billet que j’ai consacré à cette affaire un long commentaire, dans lequel il conteste l’exactitude de plusieurs des arguments que j’avance. Il défend par ailleurs le dispositif mis en place par la loi du 1er mars 2012 sur l’exploitation numérique des livres indisponibles du XXème siècle, à la conception duquel il a participé.

S’agissant d’une affaire dans laquelle on a pu déplorer un constant manque de transparence, y compris lors du vote de la loi au Parlement, je tiens à saluer ce geste de François Gèze, d’autant plus qu’un échange intéressant avec d’autres personnes a pu s’installer par la suite dans les commentaires du billet. Malgré la vigueur des critiques qui se sont exprimées contre le dispositif ReLIRE, les parties prenantes officielles n’ont pour l’instant pas engagé de débat réel. Il faut donc créditer François Gèze d’avoir pris sur lui le faire loyalement ici, alors que rien ne l’y obligeait.

Néanmoins, je tiens à répondre dans le détail à ces observations, car les commentaires de François Gèze comportent des erreurs manifestes, portant sur les termes mêmes de la loi, qu’on peut juger inquiétantes s’agissant d’un des membres du comité scientifique du Registre. Par ailleurs, François Gèze apporte des éléments d’informations concernant la constitution de la base ReLIRE qui confirment certaines des craintes que je nourrissais, notamment sur le fait que certains éditeurs auraient pu bénéficier d’un opt-in à la place de l’opt-out prévu par la loi.

Les commentaires de François Gèze figurent ci-dessous en bleu, suite aux passages de mon billet en noir. J’inclus également des commentaires laissés par d’autres personnes sous ce billet, qui peuvent apporter des éléments intéressants à la discussion.

A chacun de se faire une opinion concernant l’exactitude et la pertinence des arguments échangés.

***

Eh ben, eh ben, que dire face à tant d’ire ? Simplement que l’auteur de ce billet s’égare, étant sans doute mal informé, alors qu’il n’était pourtant pas si difficile de le faire. Quelques rectifications semblent nécessaires ;-). Et pour savoir « d’où je parle » : je dirige depuis trente ans les Éditions La Découverte et j’ai été étroitement associé, en tant que président du groupe des éditeurs universitaires du Syndicat national de l’édition, tant à la loi ici contestée qu’à sa mise en œuvre.

Les lecteurs de ce blog, qui savent que depuis plusieurs années, je veille, écris, développe des analyses et interviens sur cette question de la numérisation des livres indisponibles et épuisés, apprécieront sans doute à sa juste valeur le fait que je serais « mal informé ».

Par ailleurs, vu les erreurs commises par François Gèze sur la signification des termes de la loi, cette insinuation est entièrement réversible. Je me tiens d’ailleurs à son entière disposition pour compléter son information s’il le souhaite.

***

Calimaq : « ReLIRE comporte visiblement d’étranges erreurs. On y trouve par exemple 538 titres publiés postérieurement au 1er janvier 2001, qui ne sont donc pas couverts par la loi du 1er mars 2012. »

François Gèze : Ces titres sont, sauf erreur toujours possible, des « manifestations » (éditions) publiées de titres initialement publiés avant 2001 et aujourd’hui indisponibles : elles ont donc toute leur place dans le registre.

Voilà ici l’erreur d’interprétation de la loi du 1er mars 2012 et elle est très lourde, eu égard à ses conséquences pour les auteurs.

Contrairement à ce qu’avance François Gèze, il est manifeste que les livres publiés après le 31 décembre 2000 ne peuvent être inclus dans le Registre, y compris lorsqu’il s’agit de rééditions de titres plus anciens. Ce jugement résulte d’une mauvaise compréhension de ce qu’est une « manifestation » par rapport à une « oeuvre » (titre), termes issus du modèle FRBR.

A vrai dire, cette précision est écrite dès la page d’accueil du registre ReLIRE, qui indique : « ReLIRE vous donne accès à une première liste de 60 000 livres indisponibles du 20ème siècle : des livres sous droits d’auteur, publiés en France avant le 1er janvier 2001, et qui ne sont plus commercialisés ».

Cette page du site opère d’ailleurs bien la distinction entre les oeuvres et les éditions, en indiquant que « lorsqu’il y a dans ReLIRE plusieurs éditions d’un même livre, on appelle cet ensemble « œuvre » » et « pour qu’un livre soit considéré comme indisponible, toutes les éditions qui en contiennent le texte intégral doivent être indisponibles » (merci @BlankTextField de l’avoir signalé).

Le texte de la loi est également très clair sur cette question. L’article L. 134-1 indique :

On entend par livre indisponible au sens du présent chapitre un livre publié en France avant le 1er janvier 2001 qui ne fait plus l’objet d’une diffusion commerciale par un éditeur et qui ne fait pas actuellement l’objet d’une publication sous une forme imprimée ou numérique.

Ceux qui ont suivi attentivement l’élaboration de cette loi au Parlement (ce qui est mon cas) savent qu’il y eu une modification importante du texte en cours de route sur ce point et que le terme « oeuvre » initialement prévu dans la proposition de loi introduite par Hervé Gaymard a été remplacé suite à un amendement par le terme « livre » :

On entend par oeuvre indisponible, au sens du présent chapitre, une oeuvre non disponible commercialement de façon licite dans un format papier ou numérique, publiée en France sous forme de livre avant le 31 décembre 2000 et inscrite sur la base de données mentionnée à l’article L. 134-2.

Le juriste Franck Macrez, auteur d’une étude détaillée de la loi sur les indisponibles au Dalloz, avait d’ailleurs relevé cette variation dans le texte, en expliquant qu’elle avait des conséquences importantes en termes juridiques.

En effet, cette modification entraîne qu’il faut se placer justement au niveau des différentes « manifestations » d’un titre (ses différentes éditions), pour examiner leur disponibilité une par une, et non au niveau de « l’oeuvre » toute entière. C’est le sens que l’on doit donner au mot « livre » dans la loi, sinon le législateur aurait dit « oeuvre ».

Il en résulte que contrairement à ce qu’affirme François Gèze, les éditions d’un livre parues après le 31 décembre 2000 sont à l’évidence en dehors du périmètre de la loi et ne devraient en aucun cas figurer dans le registre.

On dira sans doute que je suis un peu taquin, mais prenons au hasard l’exemple de ces douze titres publiés aux Editions La Découverte et présents dans le Registre (merci @Thelonius_Moon de me les avoir transmis !). Ils comportent tous des éditions publiées après le 31 décembre 2000. Ces dernières sont donc en dehors du champ de la loi et n’ont rien à faire dans cette base…

C’est même pire que cela, puisque @Blanktextfield signale sur Twitter que 4 titres parmi ces 12 font partie d’une collection [Re]Découverte dont François Gèze ne peut pas ignorer l’existence et qui vise précisément à rééditer des titres du catalogue :

Grâce aux nouvelles techniques d’impression numérique, donner une seconde vie à des textes classiques, dont certains sont épuisés depuis plusieurs années pour répondre ainsi à l’attente des lecteur.

Ces rééditions sont donc disponibles (exemple) et aucune édition précédente ne devrait pas figurer dans la base (pourtant…).

Je constate donc, à ma plus grande stupéfaction, que l’un des membres du comité scientifique du registre, chargé de l’établissement des critères d’inclusion des ouvrages dans ReLIRE, et qui plus est, l’un des concepteurs mêmes de cette loi d’après ses propres propos, se trompe sur l’interprétation de ce texte.

Sans doute pourra-t-on rétorquer que cette loi est redoutablement compliquée et c’est ce qu’une juriste comme Isabelle Sivan avait relevé après la parution du texte, non sans se poser quelques questions :

La rédaction de cette loi est particulièrement complexe au point que l’on pourrait penser qu’elle cherche à semer certains de ses lecteurs ou intéressés.

Au vu du commentaire de François Gèze (dont je ne remets pas en cause la bonne foi), on constate que la complexité de cette loi est visiblement capable de perdre en cours de route l’une des personnes impliquées dans sa conception et qui représentera les éditeurs dans sa mise en oeuvre !

De là à dire que l’on a joué aux apprentis sorciers avec ce texte, il n’y a qu’un pas à franchir et je pourrais même dire « pardonnez-leur, parce qu’ils ne savent pas ce qu’ils font« , si ce n’est que ce genre d’erreur de droit est difficilement pardonnable. Car pour les auteurs en cause, cela signifie que les droits sur leurs oeuvres peuvent être placés en gestion collective, alors même que les livres en question ne sont pas couverts par la loi et qu’il est absolument illégitime de faire peser sur eux une quelconque obligation de retrait.

Ces derniers sont entièrement fondés à saisir directement la justice pour faire valoir leur droit, car l’inclusion de ces livres publiés après le 31 décembre 2000 constitue une négligence caractérisée, puisqu’un simple tri par date aurait permis de les exclure.

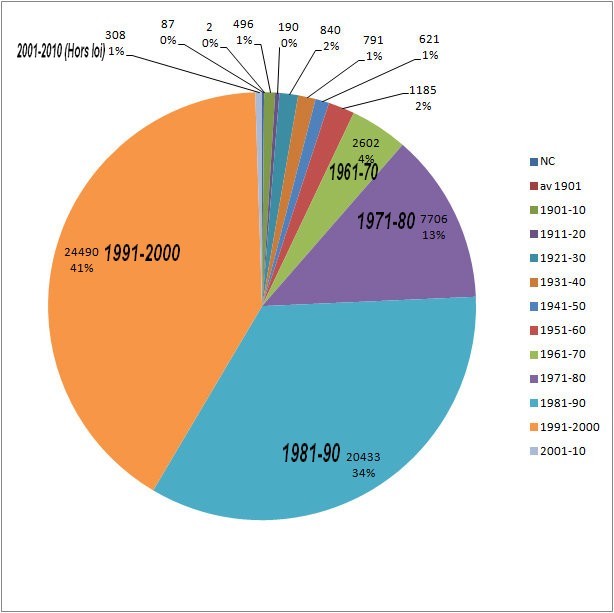

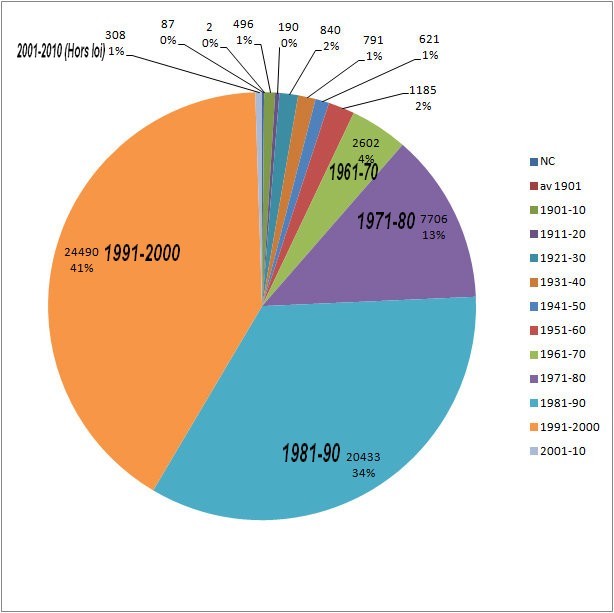

D’après les estimations faites par la Team AlexandriZ à partir du contenu de la base, la proportion de ces « dommages collatéraux » n’est pas complètement négligeable, puisque 1% de la base ReLIRE correspondrait à de tels livres hors du champ de la loi.

Voilà donc pour la première inexactitude de ma part. Passons donc aux suivantes !

***

Calimaq : « Plus surprenant encore, ReLIRE contiendrait quelques rééditions de livres publiés au 18ème et 19ème siècle, ainsi que de simples reprints, qui n’ont absolument rien à y faire… »

François Gèze : Bien sûr, de « simples reprints » d’œuvres du domaine public n’ont rien à y faire, mais le conditionnel est en effet de mise : il n’est pas si facile, vu les possibles insuffisances des bases de données bibliographiques, de vérifier si toutes les éditions de ces œuvres sont ou non de « simples reprints » et si elles ne comportent pas un appareil critique qui ne relève pas du domaine public. Et c’est précisément l’objet de la publicité donnée par la base ReLIRE de permettre que ces éventuelles anomalies soient corrigées. Comment faire autrement, SVP ?

Comment faire ? Même réponse que plus haut : un simple tri par date et on exclut ces ouvrages trop anciens, au moins à titre de précaution s’il est trop difficile d’établir s’ils sont bien concernés par la loi. C’est ainsi que nous avons fait pour les rechercher et cela n’a rien eu de bien compliqué. Il faut arrêter avec les arguments du genre : « Mais c’est compliqué de gérer une telle base ! ». 60 000 références, on est très loin du Big Data !

Pour la première parution de cette liste, on aurait été en droit d’attendre une prise de risque minimale pour éviter tout risque de contestations. S’il est difficile de distinguer les simples reprints des livres avec appareil critique, la simple prudence aurait dû conduire à exclure ces titres, surtout si le stock global des indisponibles s’élève à 500 000 livres. Quel besoin de remonter aussi loin dans le temps ?

Mais il a fallu faire vite pour constituer ce registre, notamment à des fins d’affichage politiques lors du Salon du Livre 2013. Bruno Racine se félicitait (le mot est faible…) d’avoir « tenu les délais« , comme si c’était l’alpha et l’oméga. Mais à quel prix ?

***

Calimaq « ReLIRE pousse l’ironie jusqu’à avoir mis en place un formulaire pour signaler qu’un titre figurant dans la base est en réalité disponible, comme s’il s’agissait d’une simple erreur à rectifier, alors qu’il s’agit de violations de la loi ! Je dirai ça à la police, la prochaine fois que je suis pris en excès de vitesse : merci de me le signaler ! »

François Gèze : Dios mio ! Mais où sont donc l’« ironie » et la « violation de la loi » ? Cette remarque acerbe est sans le moindre fondement, car l’établissement du statut « indisponible » est tout sauf simple (à la différence d’un radar constatant un excès de vitesse). La seule base existante mentionnant le statut d’indisponibilité d’un livre, Electre, peut comporter des erreurs, malgré tous ses efforts, car elle agrège des informations venant des distributeurs (et encore, certains petits échappent peut-être) qui peuvent parfois être erronées. De surcroît, comme l’explique justement le site ReLIRE : « Il n’existe pas en France de base de données interprofessionnelle recensant la disponibilité numérique. D’autre part, la disponibilité est très mouvante. Des erreurs sont donc possibles, et chacun est invité à les signaler à la BnF. Le registre est conçu en ce sens : il est possible de signaler la disponibilité d’une œuvre en indiquant les précisions nécessaires à sa vérification (coordonnées de l’éditeur, lien vers le site de l’éditeur, vers la fiche de l’ouvrage sur le site d’une librairie en ligne, etc.). » Mais Lionel Maurel s’est-il donné la peine de lire ces explications et de s’intéresser au vaste problème que constitue la vérification de la fiabilité des bases de données bibliographiques (y compris celle de la BNF, qui est très loin d’être sans défauts s’agissant des titres du dépôt légal antérieurs aux années 1980) ?

Sur ce point, je persiste et je signe. La loi est la loi, et nul ne peut s’abriter derrière de prétendues difficultés techniques pour ne pas la respecter. Pour prendre une autre métaphore que celle de l’excès de vitesse, lorsqu’un médecin se trompe de diagnostic et administre à tort un traitement qui cause un préjudice à son patient, il ne peut que très difficilement s’abriter derrière la difficulté technique pour s’exonérer de sa responsabilité.

C’est la même chose ici, car inclure un livre disponible dans ReLIRE cause un préjudice incontestable aux titulaires de droits sur cette oeuvre, en les forçant à se manifester pour rectifier l’erreur, au risque de voir autrement leurs droits passer en gestion collective. C’est déjà en soi très contestable, y compris sur le plan du droit, pour les livres indisponibles. Mais cela devient catégoriquement inacceptable pour les ouvrages qui sont encore disponibles !

Contrairement à ce que François Gèze sous-entend, je suis parfaitement au courant des difficultés qui existent pour établir qu’une oeuvre est indisponible ou non, ainsi que des lacunes figurant dans les bases de données (Electre ou le catalogue de la BnF).

Mais si d’un point de vue technique, la détermination de l’indisponibilité est si complexe et faillible, alors la conclusion que l’on peut en tirer, c’est qu’il ne FALLAIT PAS instaurer un système d’opt-out pour régler la question des indisponibles, car le risque de préjudice était trop grand. Le commentaire de François Gèze fait tout simplement la preuve du vice de conception fondamental de cette loi.

C’est exactement à cette conclusion qu’est arrivée la justice américaine dans l’affaire Google Books aux Etats-Unis, en rejetant le principe même de l’opt-out. Les instigateurs de la loi française auraient bien fait de se ranger à cet exemple de sagesse juridique…

***

Calimaq : « Le ridicule a été poussé jusqu’à nommer par arrêté un « conseil scientifique » le 20 mars, dont la mission consiste justement à définir les critères et la méthode d’établissement de la liste des ouvrages inclus dans la base. Or cette fameuse liste a été publiée dès le lendemain, en même temps que le Registre ReLIRE. On en déduit soit que les membres de ce conseil sont des surhommes qui ont abattu le travail de sélection de 60 000 livres en une nuit, soit que la besogne a été accomplie ailleurs – on ne sait où, par qui et comment – avec à la clé, les ratages qui éclatent au grand jour à présent. »

Mais où est le « ridicule », sinon aux yeux de celui qui ne veut pas s’informer ? Ce n’est pas parce que ce « conseil scientifique » (dont je fais partie, honte sur moi) n’a été nommé que le 20 mars qu’il aurait travaillé « en une nuit » pour établir une première liste de 60 000 titres (limitée aux sciences humaines et sociales, à l’histoire et à la fiction), soit à peine plus de 10 % du corpus estimé : à l’avenir, sa mission sera justement d’affiner les critères et les méthodes de constitution de la base. En pratique, il y a plus de trois ans que des représentants des auteurs, des éditeurs et des bibliothécaires (pas mal de professionnels, qui n’ont rien de « clandestins ») ont engagé, sous la houlette très officielle du ministère de la Culture, le travail nécessaire pour construire un dispositif, aujourd’hui contesté, dont le seul objectif est de rendre accessibles des centaines de milliers de livres épuisés du XXe siècle. La mise au point de la première liste, certainement à améliorer, a nécessité des mois de travail de beaucoup de gens – en particulier d’une équipe ad hoc de la BNF, remarquablement compétente –, consacrés à la résolution de mille problèmes purement techniques, tant la vérification d’une vraie indisponibilité est complexe.

Dans une démocratie bien comprise, les comités travaillent après avoir été officiellement nommés, de manière à ce qu’ils puissent fonctionner en conformité avec les règles posées par les actes qui les instituent. On pourra me trouver rigide, mais concernant une affaire si sensible, toutes les garanties formelles auraient dû être apportées.

François Gèze semble par ailleurs se féliciter que des travaux aient eu lieu depuis plus de trois ans à propos de l’établissement de ces listes d’indisponibles, mais c’est aussi l’un des points que les détracteurs de ce projet mettent en avant. Une grande part des négociations et travaux liées à ce projet des indisponibles s’est accomplie de manière complètement opaque, très en amont du vote de la loi.

Comme je le disais dans mon précédent billet, Il en a d’ailleurs résulté un accord-cadre conclu entre le Ministère de la Culture, le SNE, la SGDL, la BnF et le Commissariat à l’Investissement qui n’a pas été publié, alors même qu’il avait des incidences majeures sur l’emploi des crédits publics. A force d’être réclamé, notamment par des députés, ce texte a fini par être révélé, mais seulement à la fin du vote de la loi.

Le problème, c’est justement que quelqu’un comme François Gèze ne voit plus où est le problème avec ces méthodes, qui jettent le discrédit sur l’action publique et minent la légitimité des lois.

Pour l’anecdote, on espère à présent que le comité scientifique dont fait partie François Gèze va redoubler d’effort en ce qui concerne la sélection, car si cette première liste de 60 000 titres devait se limiter « aux sciences humaines et sociales, à l’histoire et à la fiction« , on peut s’étonner d’y trouver Les Roucasseries de Jean Roucas, les Eclats de rire de Lagaf ou Les meilleures histoires drôles de Carlos !*

***

Calimaq : « Une partie de ces titres a été sélectionnée dans le cadre d’un marché passé avec Electre, mais le document indique aussi que 10 000 ouvrages auraient été « fournis par les éditeurs ». Qu’est-ce que cela peut signifier ? Mystère, sinon que l’on voit que les éditeurs bénéficient en réalité sans doute d’une forme d’opt-in, puisqu’ils ont la main sur la liste, alors que les auteurs de leur côté restent individuellement soumis à l’opt-out. Cette « cuisine interne » aboutit à quelque chose de vraiment pire que tout ce que l’on pouvait imaginer ! »

François Gèze : Les éditeurs ne « bénéficient » de rien du tout : si certains d’entre eux (ceux qui avaient les fonds les plus anciens) ont été sollicités par la BNF, c’est simplement parce que, Electre ne recensant que des titres publiés depuis sa création au début des années 1980, nombre de titres publiés antérieurement et déjà épuisés à cette date ne pouvaient y figurer. Il était donc important que des éditeurs « anciens » puissent vérifier sur les listes (établies à partir de la base bibliographique de la BNF) de leurs titres antérieurs au début des années 1980 ceux qui étaient effectivement indisponibles à ce jour : je l’ai fait par exemple pour ma maison (créée en 1959) et je peux vous assurer que c’est un travail long et complexe (que beaucoup d’autres maisons devront d’ailleurs poursuivre), qui n’encourage de surcroît aucun « opt-in » (car si jamais je souhaite à l’avenir exploiter moi-même certains de ces titres épuisés, il me sera beaucoup plus facile de le faire en pratiquant l’« opt-out » sur le registre). Où est la « cuisine interne », sinon dans la vision de ceux qui n’ont pas compris le dispositif ?

Je crains hélas que François Gèze ne maîtrise pas certains termes du débat, car contrairement à ce qu’il avance dans sa réponse, son commentaire atteste bien que certains éditeurs ont bénéficié d’un opt-in, alors même que la loi a mis en place une procédure d’opt-out. C’est une distorsion majeure du dispositif, que j’avais déjà pressentie à la lecture de la révélation d’un document interne de la BnF sur Actualitté, qui indiquait que 10 000 indisponibles seraient « fournis par les éditeurs » à la BnF. On sait maintenant que c’est vrai et comment cela s’est passé, grâce à ce commentaire.

Je ne remets cependant pas en cause la bonne foi de François Gèze et je ne minimise pas la difficulté pour un éditeur d’établir une liste des indisponibles à partir de son propre fonds. Néanmoins cette faculté de choix réservée à certains de déterminer quels livres ou non figureront dans la base constitue à l’évidence une rupture d’égalité vis-à-vis de ceux – éditeurs et auteurs – qui seront soumis à l’opt-out strict prévu par la loi.

L’opt-out n’est absolument pas quelque chose d’anodin. Si l’opt-in est ouvert pour certains, il devrait être ouvert à tous : éditeurs, mais aussi et surtout, auteurs !

Lucie Chenu dans un commentaire laissé sous le billet explique bien en quoi laisser la possibilité à certains éditeurs de choisir les livres qu’ils veulent inclure dans la base constitue bien un opt-in :

Je pense que vous n’avez pas compris le propos de Calimaq (qui me corrigera si je me trompe). Ou alors, vous faites semblant. L’opt in, vous en avez déjà bénéficié lorsque vous avez eu la possibilité de choisir les titres que vous voulez inclure dans le registre.

Quand on sait le déséquilibre de traitement qui existe déjà à la base entre les éditeurs et les auteurs dans le mécanisme même de la loi sur les indisponibles (analyse détaillée ici), c’est vraiment pousser très loin que de donner en plus à certains éditeurs la possibilité de maîtriser l’entrée de leurs ouvrages dans le Registre. Dans un commentaire supplémentaire, François Gèze donne des garanties vis-à-vis de « ses » auteurs et il n’y a pas lieu de mettre sa parole en doute. Mais il ne comprend pas que c’est le principe même qui est choquant.

Dans un autre commentaire, François Gèze ajoute ceci :

Cher Lionel Maurel, je ne sais comment vous l’expliquer : je n’ai « bénéficié » de rien du tout, sauf du pénible « privilège » de vérifier titre par titre si, à ma connaissance, des titres du fonds ancien de ma maison étaient ou non indisponibles, sans que cela me donne le moindre avantage par rapport aux auteurs concernés.

Je tiens à préciser qu’il existe néanmoins une forme de privilège important à figurer ou non dans cette première liste du registre. Car la BnF a annoncé son intention de financer sur ses propres crédits la numérisation des 10 000 premiers titres (1 millions d’euros), ce qui lève pour cette tranche l’obligation de rembourser l’emprunt qui sera mobilisé par la suite pour numériser les indisponibles.

Sans remettre en cause encore une fois la bonne foi de François Gèze, est-il seulement sain dans ces conditions qu’un membre du comité scientifique puisse choisir la liste des livres de son fond qu’il inclut dans le système ? Je soulève la question.

Encore une fois tout ceci donne une impression désagréable d’arrangement par rapport aux termes mêmes de loi, qui ne peut que ternir la légitimité du processus.

***

Calimaq : « Or la directive européenne prévoyait un système différent par lequel les bibliothèques françaises, après avoir établi par des recherches diligentes que les ouvrages étaient bien orphelins, auraient pu numériser et mettre en ligne gratuitement les ouvrages à la disposition du public. Il y a fort lieu de penser que cette possibilité de diffusion gratuite a complètement affolé les titulaires de droits en France, qui ont utilisé l’artillerie lourde de leur lobbying pour neutraliser la directive au profit du système des Indisponibles. »

« Fort lieu de penser » : là, on n’est pas très loin de la paranoïa… Car les « titulaires de droits », auteurs comme éditeurs, je peux en témoigner, n’ont jamais le moins du monde été « affolés » par la perspective d’une diffusion gratuite des œuvres orphelines, puisque, par hypothèse, celles-ci n’ont plus d’ayants droit identifiables. L’article L. 134-8 de la loi a introduit simplement un délai de dix ans avant de permettre cette diffusion gratuite conforme à la directive européenne, laps de temps assez raisonnable pour s’assurer qu’une telle œuvre est vraiment orpheline et ne léser aucun ayant droit, tant la tâche est complexe (« Sauf refus motivé, la société de perception et de répartition des droits mentionnée à l’article L. 134-3 autorise gratuitement les bibliothèques accessibles au public à reproduire et à diffuser sous forme numérique à leurs abonnés les livres indisponibles conservés dans leurs fonds dont aucun titulaire du droit de reproduction sous une forme imprimée n’a pu être trouvé dans un délai de dix ans à compter de la première autorisation d’exploitation »).

Je ne sais pas si je suis paranoïaque, mais j’ai appris au fil des années à devenir extrêmement méfiant pour tout ce qui touche à la politique en direction des bibliothèques. Et il se trouve qu’il est possible de citer des déclarations d’acteurs impliqués dans ce dossier des indisponibles attestant que ce dispositif a été mis en place pour contrer la directive européenne sur les oeuvres orphelines en la prenant de vitesse.

A ce sujet, on constate par exemple un flottement surprenant dans le discours de Nicolas Georges, directeur du livre et de la lecture, qui varie en fonction de l’assistance à laquelle il s’adresse. Lors du congrès 2012 de l’ABF à Montreuil, directement interrogé sur la question, il déclare que la loi sur les indisponibles n’a jamais été conçue comme une parade contre la directive sur les orphelines. Mais quelques mois plus tard, lors d’une table-ronde organisée par la SCAM sur la loi, à laquelle j’assistais, il fera une déclaration exactement contraire, en affirmant que l’un des intérêts de cette loi était d’empêcher l’application dans le secteur du livre de la nouvelle exception prévue pour les oeuvres orphelines dans la directive. Lors du forum SGDL 2012, lors de la table ronde Internet et Droit d’auteur, ce sera au tour de Jean-Claude Bologne, président de la SGDL, de critiquer très fortement le mécanisme d’exception mis en place par la directive et de se féliciter de la mise en place de la loi sur les indisponibles, qui permettait de l’éviter. Nicolas Georges aura à cette occasion l’occasion de rappeler que le mécanisme de l’exception était pour lui un « constat d’échec » à éviter à tout prix et que la loi sur les indisponibles avait permis de l’éviter.

Que dire d’autre, sinon que je laisse les lecteurs de ces lignes juger !

Ceci étant précisé, il est également sidérant de lire que François Gèze considère que la loi du 1er mars 2012 confère aux bibliothèques une réelle possibilité de diffuser des livres orphelins. Il n’en était absolument pas question dans la proposition initiale de loi et c’est au Sénat qu’un mécanisme a été introduit, qui aurait effectivement apporté une solution assez intéressante à ce problème, en permettant aux bibliothèques de diffuser les oeuvres non réclamées dans le Registre au bout d’un délai de 10 ans.

Mais la moulinette de la navette parlementaire est lourdement passée sur cette partie du texte, jusqu’à réduire l’article L.134-8 à un véritable trompe-l’oeil. Un lobbying d’enfer a d’ailleurs été exercé sur les représentants afin qu’ils fassent machine arrière, dont le député Patrick Bloche s’était même plaint lors des débats de la Commission Mixte Paritaire :

Le lobbying que nous avons subi, avant la CMP, sur cet article, m’a choqué. A croire que l’accord entre auteurs et éditeurs est si parfait que le législateur n’aurait plus qu’à l’enregistrer.Mais c’est notre légitimité d’élus du suffrage universel qui doit nous guider, pour trouver un point d’équilibre : nous sommes là pour faire la loi. Et que l’on ne vienne pas me dire que nous sortons de notre rôle : il nous revient de prendre en compte, faut-il le rappeler, des objectifs d’intérêt général. C’est le cas sur ce sujet des livres indisponibles, auxquels les enseignants, les chercheurs, doivent pouvoir avoir accès.

Voilà la triste vérité… Et au final, il ne reste quasiment plus rien de ce qui avait été introduit par le Sénat : les bibliothèques devront attendre 10 ans avant de diffuser les oeuvres orphelines parmi les indisponibles, mais uniquement en les renumérisant à leurs frais, pour une diffusion non pas en ligne, mais sur des extranets sécurisés à leurs seuls usagers. Et pire que tout, la Société de gestion collective en charge des indisponibles conservera la faculté, titre à titre, d’apprécier discrétionnairement (« sauf refus motivé ») si les bibliothèques pourront ou non diffuser les ouvrages orphelins !

Conçu sciemment pour être inapplicable, ce mécanisme est infiniment en retrait par rapport à la directive européenne, même si celle-ci est loin d’être si ouverte que les titulaires de droits français le disent.

Sur ce point encore, je ne peux suivre François Gèze.

***

Calimaq : « Des alternatives existaient, qui auraient permis de mettre en place des solutions bien plus équilibrées, sans tordre le cou aux principes les plus essentiels du droit d’auteur. Concernant les œuvres indisponibles, la seule solution équitable était celle du retour automatique des droits à l’auteur et l’inclusion des œuvres dans le registre sur la base d’un opt-in strict. »

« Inclure des œuvres [indisponibles] dans le registre sur la base d’un opt-in strict » : cela revient à attendre, avant de commencer la numérisation de masse (seul moyen de maintenir les coûts de cette opération à un niveau raisonnable), que plusieurs dizaines de milliers d’auteurs et d’ayants droit aient exercé cet opt-in. Autant dire jamais, ou plutôt attendre quelques décennies que toutes ces œuvres tombent dans le domaine public. Il serait plus honnête de dire franchement que c’est le projet même de rendre dès maintenant disponible les livres disparus du XXe siècle qui doit être abandonné. Il faudrait d’autres arguments pour prouver que la loi de 2012 « tord le cou aux principes les plus essentiels du droit d’auteur », alors même – et les auteurs y ont veillé –, qu’elle met leurs droits en avant en leur permettant l’opt-out.

Il est certainement très efficace d’un point de vue rhétorique de laisser penser que cette loi, avec son opt-out, constituait le seul moyen de permettre la numérisation des livres indisponibles du 20ème siècle. Mais c’est manifestement faux.

La preuve, c’est l’attitude que les éditeurs français ont eu vis-à-vis de Google et de ses projets de numérisation. On sait en effet que des éditeurs comme Hachette et Le Seuil/La Martinière ont accepté des partenariats avec Google, pour la numérisation de livres hors commerce, à la condition que le moteur de recherche revienne à un opt-in strict, tant pour les éditeurs que les auteurs. Le SNE a même signé par la suite un accord-cadre avec Google sur les mêmes bases.

Les chiffres annoncés dans le cadre de ces partenariats sont assez considérable, puisqu’on parlait de 50 000 ouvrages pour Hachette. Si l’opt-in est impossible à mettre en oeuvre comme l’insinue François Gèze, comment est-il possible que de tels partenariats aient été signés avec Google ?

La question se pose d’ailleurs sérieusement (et je l’avais déjà fait), de l’articulation entre la mise en oeuvre de la loi sur les indisponibles et celle des partenariats signés avec Google. Un éditeur comme Hachette est également présent dans ReLIRE et j’avais d’ailleurs indiqué que des risques de « porosité » entre les deux initiatives étaient tout à fait possibles.

L’opt-in strict est le seul moyen d’aborder le problème de la numérisation des indisponibles dans le respect des droits des auteurs et les nombreux ratés de ReLIRE prouvent que cette précaution était essentielle. C’est aussi sur ce point que la loi du 1er mars 2012 soulève le plus de critiques, quant à sa compatibilité avec la Constitution et la Convention de Berne.

Si des difficultés insurmontables se posent à propos d’un partie du corpus, c’est alors que les ouvrages sont orphelins et c’est un des autres vices majeurs de cette loi, d’avoir voulu traiter les oeuvres orphelines au sein des livres indisponibles sans les distinguer. C’était aussi précisément ce que la justice américaine avait reproché à Google et la France n’a pas fait mieux. Pour ces livres orphelins, c’est le mécanisme de la directive, beaucoup plus cohérent, qui devrait s’appliquer.

C’est Philippe Aigrain qui a vu le plus juste à propos de la loi sur les indisponibles, lorsqu’il dit qu’elle constitue « un plan concerté pour la destruction d’un possible« . Ce possible, à base d’opt-in et de solution adaptée au cas spécifique des orphelines, aurait été respectueux à la fois des intérêts des auteurs et de ceux du public.

Mais il faut croire que d’autres intérêts sont plus puissants que ceux-là en France…

***

Calimaq : « Pour mettre en œuvre la base ReLIRE, le gouvernement devait nécessairement prendre un décret, mais publier cet acte, c’était exposer le flanc à un recours au Conseil d’État et plus loin ensuite, devant le Conseil constitutionnel qui a le pouvoir d’annuler la loi. »

Euh, alors là, je ne sais vraiment plus si Lionel Maurel sait encore de quoi il parle, car le décret en question a bien été publié, le 1er mars 2013, il est là :

http://www.legifrance.gouv.fr/affichTexte.do?cidTexte=JORFTEXT000027119991&dateTexte=&categorieLien=id

comme il le signalait d’ailleurs lui-même au début de son billet, qu’il semble avoir oublié à la fin…

Sur ce point, je dois reconnaître que ma phrase ne devait pas être claire, si elle a fait croire à François Gèze que je sous-entendais que le décret n’avait pas été publié. Ce n’est pas du tout ce que j’ai voulu dire et j’avais d’ailleurs procédé à une analyse détaillée des impacts de ce décret ici.

Ce que je voulais dire, c’est justement que la publication de ce décret ouvre la possibilité d’une contestation de cet acte devant le Conseil d’Etat et à partir de ce recours, la possibilité d’atteindre le Conseil constitutionnel pour faire tomber la loi elle-même.

Et c’est sans doute ce qui va se passer dans les semaines à venir…

***

Calimaq : « Pour beaucoup, l’ouverture de la base ReLIRE a ajouté l’insulte à la blessure qu’avait constitué le vote de la loi du 1er mars 2012. Mais la réaction est déjà en marche et elle sera à la mesure du mépris dont les instigateurs de ce texte ont fait preuve ! »

Ni « insulte » ni « blessure », donc, mais la « réaction », en effet. Car il est difficile de ne pas trouver assez « réactionnaire » cette démonstration si mal ficelée, qui semble plaider de facto pour le maintien dans les ténèbres des centaines de milliers de livres indisponibles du XXe siècle, alors même que nombre de bibliothécaires râlent de longue date contre les éditeurs qui ne les republient pas (essentiellement faute d’acheteurs qui permettraient de couvrir les coûts de réédition) et dont le numérique rend enfin possible économiquement la renaissance…

Démonstration « si mal ficelée »… Au vu des failles béantes dans les arguments de François Gèze, je pense que le lecteur appréciera cette saillie à sa juste valeur.

L’accusation d’obscurantisme est aussi sans fondement, car ce que je défends, c’est qu’il y avait d’autres voies pour traiter la question des indisponibles, comme je l’ai indiqué plus haut. Celle qui a été choisie n’est que le reflet d’un rapport de forces politiques complètement déséquilibré en faveur de certains acteurs de l’écosystème.

Je remercie François Gèze d’être venu débattre ici, mais aucun de ces arguments ne m’a convaincu. Les erreurs qu’il commet, alors même qu’il siège au conseil scientifique de ReLIRE, me confortent même dans l’idée que tout ce processus ne peut conduire à présent qu’à une catastrophe.

Je terminerai en lui posant une question : si cette loi est finalement jetée à terre par une décision du Conseil Constitutionnel, que restera-t-il de tous ces efforts déployés ? Ce sera un épouvantable gâchis, qui aurait pu être évité si seulement un véritable débat public avait eu lieu.

Ce sera la grande leçon à tirer de cette affaire des indisponibles pour l’avenir.

Classé dans:

Bibliothèques, musées et autres établissemerents culturels,

Des lois et des débats Tagged:

auteurs,

éditeurs,

livres indisponibles,

Numérisation,

oeuvres orphelines,

ReLIRE