L’oeuvre, le mythe et le domaine public (Réponse à Alexandre Astier)

samedi 7 décembre 2013 à 20:07Avertissement préalable : suite à la publication de ce billet, Alexandre Astier est venu discuter sur Twitter et l’échange fut constructif et intéressant, ce qui est très rare sur ces questions. J’insère ci-dessous certains des tweets d’Alexandre Astier. La suite du billet doit être lue à la lumière de ces déclarations, qui sont sensiblement différentes des propos qui ont pu être tenus lors de l’émission Ce soir (ou jamais !) ou qui les éclairent autrement ("K " veut dire Kaamelott). Alexandre Astier autorise les usages pédagogiques de son oeuvre ; il autorise aussi les fanfictions s’inscrivant dans son univers et on peut discuter avec lui d’une éventuelle réduction de la durée du droit d’auteur.

@Calimaq La matière de Bretagne est libre. K est privée, pour l’instant, avant de se fondre dans le reste. Je suis assez à l’aise avec ça.

—

Alexandre Astier (@sgtpembry) December 07, 2013@Calimaq Par exemple, tout ce que je fais est gratuitement diffusable dans tous le cadre scolaire. Ce n’est pas exclusif au domaine public !

—

Alexandre Astier (@sgtpembry) December 07, 2013@Calimaq Oui. J’autorise les fanfictions, K en stop motion Lego, dans les écoles, dans le théâtre amateur, les spin-off, etc.

—

Alexandre Astier (@sgtpembry) December 07, 2013@Calimaq Parce que j’ai vu des gars qui me donnaient un paquet de scripts K dans les mains en me disant: 1/2

—

Alexandre Astier (@sgtpembry) December 08, 2013@Calimaq “Je tiens à être sur le plateau quand ça se tournera.”

Je crois que vous n’imaginez pas les trucs qui m’arrivent.

—

Alexandre Astier (@sgtpembry) December 08, 2013***

Vendredi dernier, j’ai participé à Ce soir (ou jamais !) sur France 2, dans une émission intitulée "Tintin, Astérix, James Bond, Yves Saint Laurent : y a t-il une vie après la mort du créateur ?". Frédéric Taddeï a souhaité en effet rebondir sur le débat suscité en octobre dernier par les déclarations parues dans le Monde de Nick Rodwell, mari de la veuve d’Hergé et gestionnaire des droits sur Les Aventures de Tintin via la Société Moulinsart. Celui-ci avait en effet annoncé son intention de publier un nouvel album de Tintin en 2052, pour essayer d’empêcher que l’oeuvre d’Hergé n’entre dans le domaine public (contre la volonté exprimée par l’auteur de son vivant). Pier-Carl Langlais avait réagi à ces propos sur Rue89 et je l’avais fait aussi de mon côté sur Slate, car il peut paraître assez choquant de voir un héritier chercher à arracher une oeuvre du domaine public et cela rappelle funestement l’allongement de la durée des droits votée en 1998 aux États-Unis sous la pression de la Walt Disney Company, juste avant que le personnage de Mickey n’entre dans le domaine public.

Qu’est-ce qui fait la différence entre une oeuvre et un mythe ? (Image tirée de "La quête du Saint Graal et la mort du roi Arthur". Domaine public. Source : Wikimedia Commons)

Le débat sur le plateau de Ce soir (ou jamais !) a bien confirmé que Rodwell avait l’intention de tenter quelque chose, sans que l’on puisse savoir exactement quoi. Mais une autre personne était présente parmi les invités, qui était directement concernée par cette question du domaine public. Il s’agissait d’Alexandre Astier, auteur-réalisateur-acteur de la série télévisée Kaamelott, s’inscrivant dans l’univers de la Légende arthurienne et de la quête du Graal. A vrai dire, on ne pouvait trouver meilleur exemple de ce que permet l’ouverture du domaine public en terme de réutilisation de personnages préexistants pour créer une nouvelle oeuvre. Et Alexandre Astier est aussi allé puiser dans le domaine public à l’occasion de son récent spectacle "Que ma joie demeure !" consacré au compositeur Jean-Sébastien Bach.

Or lors de l’émission – et il me semble que ce furent les échanges les plus intéressants de la soirée -, Alexandre Astier a tenu des propos contradictoires sur le domaine public. D’un côté, il a admis que les oeuvres comme les Aventures de Tintin avaient une dimension particulière et qu’elles tendaient à devenir des "mythologies" destinées à être "remâchées comme du chewing-gum" à travers les époques (métaphore qui fait furieusement penser au mashup). Mais lorsqu’on lui a fait remarquer que lui-même avait réutilisé des éléments du domaine public pour créer à son tour, il s’est subitement raidi, allant jusqu’à dire "si vous écrivez, écrivez vos trucs, les gars. Ne venez pas chercher les autres". Et lorsqu’on lui oppose que c’est pourtant ce qu’il a fait avec Kaamelott, il répond que la Légende arthurienne n’est "pas une oeuvre", mais "un mythe" et qu’on ne peut pas la comparer avec les Aventures de Tintin.

N’ayant pas eu le temps de répondre sur le fond à Alexandre Astier pendant l’émission, je voulais le faire dans ce billet, pour montrer que cette conception minimise certains fondements profonds de la création, qui puise toujours à des degrés divers dans ce qui a existé auparavant ("Nous sommes des nains assis sur les épaules des géants"). Alexandre Astier illustre ainsi le fait qu’une grande partie des créateurs aujourd’hui oublient la dette fondamentale qu’ils ont vis-à-vis du domaine public et c’est l’une des sources majeures du déséquilibre du système de la propriété intellectuelle.

Ecouter la légende aux portes des oeuvres et les oeuvres aux portes de la légende

La distinction qu’Alexandre Astier fait entre "l’oeuvre" et le "mythe" ou la "légende" me paraît contestable. Il n’y a qu’une différence de degré, mais pas de nature entre les deux, car c’est finalement le travail du temps, au fil des réutilisations d’une oeuvre qui transforme les créations en légende ou en mythe.

La page Wikipédia "Liste d’oeuvres concernant le cycle arthurien" montre bien ce lent processus d’alluvionnement, qui fait que l’accumulation successive des oeuvres reprenant les mêmes histoires et les mêmes personnages transforment leur nature. Tout comme la droite est une succession de points, le mythe est bien une succession d’oeuvres créées par des auteurs, même si leur nom finit par disparaître avec le temps. Issu de la synthèse entre des légendes celtiques et bretonnes et d’élements issus du Christianisme, le "fonds commun" de la légende arthurienne a été ensuite cristallisé par des auteurs médiévaux, avec un rôle particulier joué par Chrétien de Troyes au XIIème siècle. Les personnages, les événements et les lieux du la Quête du Graal sont ensuite sans cesse repris, modifiés, augmentés par des auteurs successifs, jusqu’à l’époque contemporaine où la Légende arthurienne continue à alimenter l’imaginaire des créateurs. Notre appréhension de l’histoire d’Arthur et des chevaliers de la Table ronde est aujourd’hui par exemple indissociable du film Excalibur de John Boorman, de l’Enchanteur de Barjavel, des Dames du Lac du Marion Zimmer Bradley, du Merlin de Disney ou encore, bien entendu, de Sacré Graal des Monthy Python dont la veine parodique a plus d’un lien avec Kaamelott.

Kaamelott est l’un des maillons d’une longue chaîne d’oeuvres qui ont forgé au fil du temps le cycle du Graal et nul doute que la légende continuera encore longtemps, augmentée de l’apport d’Alexandre Astier. Dans la dynamique de la création, il y a donc un lien profond entre les oeuvres et les mythes. Les oeuvres vont souvent chercher leurs inspirations dans des mythes et les mythes sont régénérés et augmentés périodiquement par les oeuvres, sans quoi ils tomberaient dans l’oubli.

Le cycle de la création

Il se trouve que ce grand "cycle" de la création a très bien été décrit par l’américain Joseph Campbell dans son ouvrage de 1949 "Le héros aux mille et un visages", dont j’ai eu déjà l’occasion de parler dans S.I.Lex. Campbell soutient qu’un très grand nombre d’histoires peuvent se ramener à un schéma narratif archétypique, qu’il nomme le "voyage du héros". Cette structure constitue à ses yeux un "monomythe" qui constitue la matrice de la plupart des grands récits de l’Humanité.

Mais loin d’être limité aux mythes et aux contes traditionnels, le pouvoir explicatif de la théorie du monomythe s’applique en réalité à de très nombreuses créations contemporaines. Georges Lucas par exemple reconnaissait sa dette vis-à-vis de l’ouvrage de Campbell pour l’écriture de Star Wars et de plusieurs analyses ont mis en évidence la présence de la même structure sous-jacente dans de nombreux récits contemporains, que ce soit Harry Potter, Le Seigneur des anneaux ou même… Le monde de Nemo !

Avec Kaamelott, ce jeux des influences est encore plus riche et complexe, car la série puise bien plus largement que dans la Légende du Graal. On y retrouve des traces de l’Univers fantasy des jeux de rôles (Donjons & Dragons, Warhammer) ; des références plus ou moins directes à l’univers d’Astérix, de Star Wars ou de Stargate, des liens avec Sacré Graal ou la série La Vipère noire, de Rowan Atkinson (Mister Bean). Tout ceci fait de Kaamelott un grand mélange et un carrefour entre beaucoup d’influences : un amalgame d’éléments légendaires et d’oeuvres, pour former quelque chose de nouveau.

Loin de moi l’idée d’insinuer que Kaamelott n’est pas une création originale, au sens que le droit attribue à ce terme (portant l’empreinte de la personnalité de l’auteur) ou de diminuer le mérite d’Alexandre Astier. Mais l’originalité n’est justement pas la nouveauté et ce qui fait l’intérêt de Kaamelott, c’est précisément la manière dont des figures immémoriales (Arthur, Guenièvre, Lancelot, Perceval, Merlin, etc.) ont été "télescopées" par Astier de manière complètement anachronique avec des références récentes et notre langage d’aujourd’hui. Du coup, entendre quelqu’un comme Alexandre Astier dire : "si vous écrivez, écrivez vos trucs, les gars. Ne venez pas chercher les autres", a vraiment du mal à passer, car il est l’exemple même de ces auteurs qui ont "recyclé" au sens le plus noble du terme des éléments préexistants.

Et tout cela n’a été possible que grâce à l’existence du domaine public.

Tintin au pays du Folklore

Faut-il maintenant faire une distinction entre la Légende arthurienne et les Aventures de Tintin ? Bien sûr, Tintin n’est pas né dans la "vallée du Floklore" pour reprendre cette belle expression inventée par Aymeric Mansoux, à une époque où les oeuvres naissaient et restaient dans le domaine public. C’est une oeuvre moderne, issue du travail créatif d’Hergé et elle porte la marque d’un seul auteur. Mais si nous le voyons ainsi, c’est aussi parce que nous ne pouvons pas encore connaître l’avenir et savoir si Tintin accèdera un jour au statut de mythe. A vrai dire, certaines oeuvres créées au 20ème siècle par des auteurs uniques ont rapidement acquis une dimension qui les rapproche des mythes d’antan. C’est le cas par exemple de Star Wars de Georges Lucas ou du Seigneur des Anneaux de Tolkien (aussi peut-être des comics américains). C’est le cas en réalité des "oeuvres univers", qui font davantage que raconter une histoire et dessinent un "monde" avec une galerie de lieux et de personnages. Or l’univers de Tintin présente de telles caractéristiques.

Galerie des personnages des Aventures de Tintin, dessinée par Hergé sur les pages de garde des albums.

Juridiquement, Tintin et Arthur n’ont pas une nature différente : ce sont tous deux des personnages que les juges acceptent de considérer comme protégeables en eux-mêmes par le droit d’auteur lorsqu’ils ont suffisamment de caractéristiques originales. La différence, c’est bien qu’Arthur est dans le domaine public, ce qui le rend disponible pour toutes les réutilisations, alors que Tintin reste protégé par le droit d’auteur, et fait l’objet d’un contrôle féroce exercé par la société Moulinsart. C’est ce qui m’a fait dire au cours de l’émission que nous sommes en réalité la première époque dans l’histoire qui se refuse à elle-même que ses oeuvres accèdent au statut de mythes, à cause d’une conception déséquilibrée de la propriété intellectuelle. Si Rodwell parvient artificiellement à prolonger les droits sur Tintin, alors il n’entrera pas dans le domaine public et il ne pourra pas faire l’objet d’appropriations et de réinterprétations libres, à l’image de celle qu’Astier a pu faire à partir de l’histoire de la Quête du Graal. Et le cas de Rodwell n’est pas isolé, puisque d’autres ayant droits s’efforcent en ce moment d’empêcher des oeuvres majeures du 20ème siècle d’entrer dans le domaine public (Sherlock Holmes, Zorro, Tarzan).

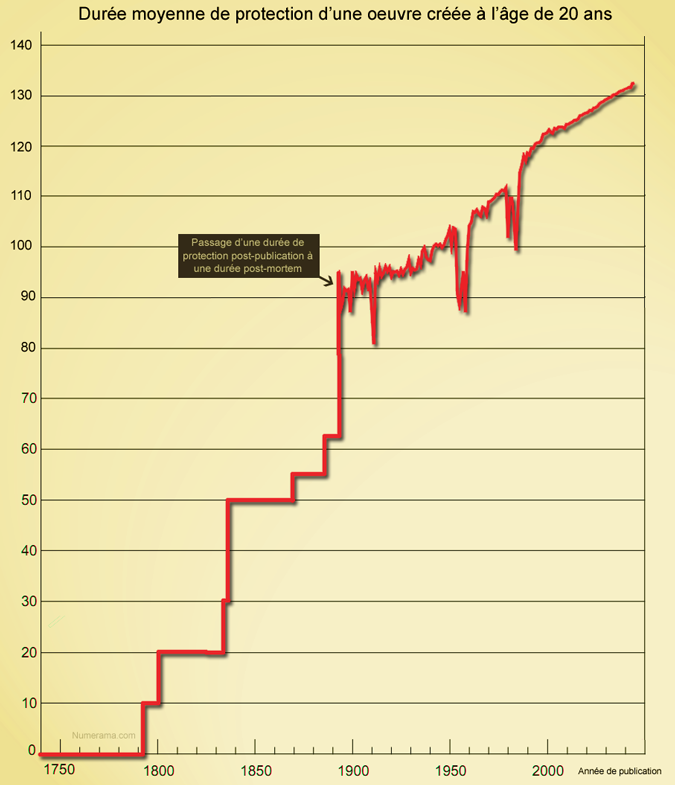

Ce faisant, on s’éloigne d’ailleurs complètement de l’esprit originel du droit d’auteur. En 1791, à la Révolution, lorsque le droit d’auteur fut créé en France, il durait seulement pendant 10 ans après la publication de l’oeuvre, ce qui permettait rapidement qu’elle accède au domaine public et que le public s’en empare. Le Chapelier, le représentant qui fut le rapporteur de cette première loi sur le droit d’auteur, concevait les oeuvres comme des propriétés de l’auteur, mais il ajoutait : "Lorsqu’un auteur fait imprimer un ouvrage ou représenter une pièce, il les livre au public, qui s’en empare quand ils sont bons, qui les lit, qui les apprend, qui les répète, qui s’en pénètre et qui en fait sa propriété. " Et c’est préciser cette appropriation par le public, qui constituait un mécanisme essentiel dans la création des contes et des mythes, qui est bloqué aujourd’hui à cause des restrictions imposées par le droit d’auteur, ainsi que par la durée très longue des droits. Ce qui était libre au bout de 10 ans ne l’est aujourd’hui qu’après presque un siècle et demi…

Harry Potter a déjà des milliers d’auteurs…

Lors de l’émission, il n’a finalement été question que des suites que des auteurs professionnels pouvaient donner à des oeuvres après la mort de leur créateur, mais nous n’avons pas pu parler des productions amateurs, qui constituent pourtant un aspect important de la créativité aujourd’hui sur Internet. Il en existe sans doute sur Tintin, mais elles sont obligées plus ou moins de se cacher, étant donné que la Société Moulinsart a déjà attaqué en justice des sites de tintinophiles.

Mais d’autres titulaires de droits n’ont pas la même attitude et c’est le cas par exemple de J.K. Rowling, l’auteur de Harry Potter, qui accepte assez largement les fanfictions s’inscrivant dans son univers et reprenant ses personnages. Elle a posé des limites, comme le fait de ne pas faire d’usage commercial ou de mettre en scène ses personnages dans des situations pornographiques, mais en dehors de ces restrictions, les créations dérivées réalisées par les amateurs foisonnent sur Internet et forment des communautés d’écriture et de partage (fandoms). Cela signifie donc que Rowling accepte qu’Harry Potter ait des milliers d’auteurs partout dans le monde, dès maintenant de son vivant, sans attendre le passage de l’oeuvre dans le domaine public. Elle accepte aussi que l’univers dont elle a planté le décor s’enrichisse de nouveaux personnages, de nouveaux lieux, de nouvelles histoires, qui s’inscrivent dans les "creux" qu’elle a pu laisser. L’univers d’Harry Potter se développe ainsi, en dehors de son auteur, d’une manière qui rappelle beaucoup la génération des mythes.

La Gazette du Sorcier, l’un des hauts points de rassemblement de la communauté du fandom d’Harry Potter en France.

Ce phénomène des fanfictions, qui explose avec Internet, nous ramène directement à la citation de Le Chapelier. Il manifeste cette propension du public à "répéter", "se pénétrer" des oeuvres et "en faire sa propriété", par l’activité créative. Et c’est là que l’on se dit aussi qu’Alexandre Astier passe à côté de quelque chose de fondamental dans la dynamique actuelle de la création, en disant "si vous écrivez, écrivez vos trucs, les gars." Une des différences majeures entre Tintin et Harry Potter, c’est que le second peut disposer d’une communautés de fans créatifs qui font vivre dès aujourd’hui cet univers et qui participent à son élévation au rang de mythe moderne, tandis que la protection tatillonne de Nick Rodwell fait que Tintin n’a quasiment plus aujourd’hui que des consommateurs passifs. Et c’est à mon sens un facteur d’appauvrissement et de dévitalisation de l’oeuvre, beaucoup plus que de protection.

A un moment donné de la discussion lors de l’émission, Alexandre Astier a pris l’exemple des LEGO, qui ont perdu l’essentiel de leur protection par la propriété intellectuelle et sont quasiment passés dans le domaine public. Or pour lui, cela n’avait aucun intérêt, sinon de permettre à des concurrents de faire des copies de mauvaise qualité. Mais cette ouverture a bel et bien un intérêt : des fans des LEGO organisés en communautés peuvent maintenant librement produire de nouvelles pièces et customiser des éléments. Et par exemple, on trouve sur Internet une gamme de LEGO Sacré Graal que la firme danoise n’aurait sans doute jamais produite d’elle-même. De l’intérêt du domaine public et de l’ouverture…

Le domaine public protège, surtout de l’oubli…

Lors du livetweet de l’émission vendredi soir, l’auteur de nouvelles Neil Jomunsi a fait un lien très pertinent entre le sujet de l’émission et le cas de H.P. Lovecraft, l’auteur du mythe de Cthulhu :

Prenez Lovecraft : un type qui de son vivant, incitait ses amis à reprendre et modifier ses créations. Lovecraft inventeur des CC.

—

Neil Jomunsi (@NeilJomunsi) December 06, 2013@Calimaq Oui. C'est même un des seuls auteurs pour lesquels on parle de mythologie. Sa création l'a dépassé. Et il en était ravi.

—

Neil Jomunsi (@NeilJomunsi) December 06, 2013Lovecraft est en effet un exemple d’auteur qui a délibérément laissé d’autres écrivains reprendre de son vivant les personnages et l’univers qu’il avait créés afin qu’ils le développent et l’enrichissent. Et sans doute n’est-ce pas étranger au fait que Lovecraft avait d’emblée eu la volonté de créer une mythologie moderne, avec sa cohorte de Dieux et sa cosmogonie. Ce choix de l’ouverture eut une importance capitale dans la destinée de son oeuvre, car Lovecraft rencontra durant toute sa vie les plus grandes difficultés à se faire publier et à toucher un lectorat. Ce n’est que parce qu’il réussit en somme à créer de son vivant autour de son oeuvre une communauté de "fans" créatifs que celle-ci a pu ensuite être reconnue comme une des créations majeures du XXème siècle. D’une certaine manière, Lovecraft a choisi de faire comme si son oeuvre était déjà dans le domaine public avant sa mort. Pourtant ironiquement après sa disparition, certains de ses collaborateurs ont essayé de se réapproprier son oeuvre et de la placer sous copyright, ce qui a d’ailleurs perturbé son entrée définitive dans le domaine public à la fin des années 2000…

Dans le cas de Lovecraft, l’ouverture l’a protégé de ce qu’il peut peut-être y avoir de pire pour un auteur : l’obscurité et l’oubli.

La tombe de Lovecraft, avec une peluche de Cthulhu déposée par un fan… (Par StrangeInterlude. CC-BY-SA. Source : Flickr)

***

Écrivez vos propres histoires ! Ne volez pas celles des autres ! J’avouerais avoir été terriblement déçu par ces propos d’Alexandre Astier, moi qui ait passé des heures et des heures à voir et revoir les saisons de Kaamelott. Il faut que nous ayons perdu beaucoup en sagesse pour oublier à ce point la dette que nous avons vis-à-vis du domaine public. Suprême ironie au début de l’émission, Frédéric Taddeï a demandé à Alexandre Astier où en était son projet d’adaptation de Kaamelott en film, dont on parle depuis un certain temps. Et Astier a répondu qu’il était toujours bloqué "à cause de problèmes de droits d’auteur"…

On lui souhaite qu’il n’ait pas à attendre l’entrée de Kaamelott dans le domaine public pour pouvoir porter à l’écran sa propre création. Car il sera mort à ce moment et avec lui, tous ses fans…

PS : @_Quack1 m’a signalé sur Twitter qu’Alexandre Astier a utilisé pour écrire Kaamelott une méthode développée par l’américain Christopher Vogler, qui travaille avec Hollywood. Or celle-ci repose en partie sur les travaux de Joseph Campbell dont j’évoque plus haut. Je l’ignorais lorsque j’ai inséré cette référence dans ce billet. Astier en parle dans cette vidéo :

Classé dans:Domaine public, patrimoine commun Tagged: Alexandre Astier, Ce soir (ou jamais !), Domaine public, droit d'auteur, Frédéric taddéï, Harry Potter, Kaamelott, Lovecraft, Nick Rodwell, Tintin