Nosferatu, victime d’un copyfraud vampirique sur YouTube ?

lundi 25 novembre 2013 à 07:27Depuis quelques mois, une chaîne s’était ouverte sur Youtube, consacrée exclusivement à la diffusion de films anciens appartenant au domaine public. Intitulée MrDomainePublic, cette chaîne apportait une valeur ajoutée substantielle, car les films étaient accompagnés de sous-titres en français.

On pouvait y voir notamment de grands classiques du cinéma, comme le Voyage dans la Lune de Méliès, M. Le Maudit et Metropolis de Fritz Lang ou encore Nosferatu le vampire de Friedrich Wilhem Murnau, qui va particulièrement nous intéresser dans ce billet.

L’appartenance des oeuvres cinématographiques au domaine public est beaucoup plus difficile à déterminer que pour d’autres types de créations, car plusieurs couches de droits se superposent : les droits d’auteur susceptibles d’appartenir à plusieurs personnes (réalisateur, scénariste, dialoguiste, auteur de l’adaptation, compositeur de la musique), les droits voisins du producteur qui prend l’initiative de fixer l’oeuvre sur un support, les droits voisins des acteurs en tant qu’interprètes. Tout ceci fait que déterminer si un film appartient ou non au domaine public relève d’un véritable casse-tête…

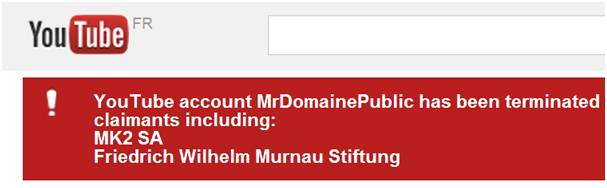

La chaîne MrDomainePublic présentait l’intérêt de donner un accès facilité à ces films du domaine public, mais elle a été rapidement rattrapée par des difficultés juridiques. Depuis deux semaines, YouTube indique en effet que la chaîne a été suspendue, suite à des "notifications multiples émanant de tiers se plaignant d’une violation de leurs droits d’auteur". YouTube mentionne les noms de deux de ces titulaires de droits : MK2 SA et la Friedrich Wilhem Murnau Stiefung.

S’il est difficile de savoir de quels films exactement MK2 a demandé le retrait, il est plus que probable que la Friedrich Wilhem Murnau Stiefung (Fondation Murnau) est intervenue de son côté pour violation des droits sur Nosferatu le vampire. Ce grand classique du cinéma fait pourtant partie des exemples que l’on cite fréquemment de films appartenant au domaine public et c’est sous ce statut que vous le trouverez notamment sur Internet Archive.

Quel fondement juridique la Fondation Murnau peut-elle bien invoquer pour demander le retrait de ce film, s’il appartient au domaine public ? L’affaire semblait étrange et j’ai essayé de creuser pour essayer de comprendre. Vous allez voir qu’en réalité, il se pourrait bien que l’ombre du droit d’auteur plane toujours sur Nosferatu le vampire, du moins en Europe. Mais même si le film est bel et bien protégé, la plainte de la Fondation Murnau n’en reste pas moins particulièrement critiquable, quand on connaît l’histoire très particulière du film Nosferatu le vampire, qui a failli être perdu à tout jamais à cause d’un conflit survenu entre Murnau et la veuve de Bram Stoker, l’auteur de Dracula.

Nosferatu toujours sous droits en Europe ?

J’avais du mal à comprendre sur quelle base la Fondation Murnau avait agi, lorsque je me suis aperçu que l’article Nosferatu le vampire sur Wikipédia était illustré avec des images du film dans la version anglaise, mais pas dans la version française. En cliquant sur l’une des images, on se rend compte que les mentions de droits indiquent que Nosferatu est bien libre aux États-Unis, en vertu de la règle spécifique à ce pays selon laquelle toutes les oeuvres publiées avant 1923 sont réputées appartenir au domaine public. Mais Wikipedia (dont encore une fois, il faut souligner la qualité des informations juridiques) prévient que cela peut ne pas être le cas dans d’autres pays.

Le réalisateur F. W. Murnau est décédé en 1931, ce qui fait que les droits le concernant sont bien échus en Europe, du fait de la règle des 70 ans de protection après la mort de l’auteur. Mais en creusant un peu, on se rend compte que le scénariste du film, Henrik Galeen, est mort en 1949. Or en matière d’oeuvre de collaboration, comme c’est le cas d’un film, on doit prendre en compte la date de décès du dernier auteur à être resté en vie pour calculer la durée des droits. Nosferatu est donc bel et bien protégé au moins jusqu’en 2020 en Europe.

La Fondation Murnau n’a pas été créée par les descendants du célèbre réalisateur pour gérer les droits sur son oeuvre. Il s’agit plutôt, comme on peut le lire ici, d’une institution chargée de conserver une partie des archives du cinéma allemand, notamment des années 1920 à 1960. Ses collections proviennent en grande partie de confiscations de collections de films intervenues après la seconde guerre mondiale et dont les droits lui ont été attribués pour qu’elle se finance en les exploitant. Par ailleurs, la Fondation Murnau a aussi une activité de restauration de films et elle a justement procédé en 2005 à la numérisation de Nosferatu le vampire, à partir de plusieurs bobines conservées en Europe.

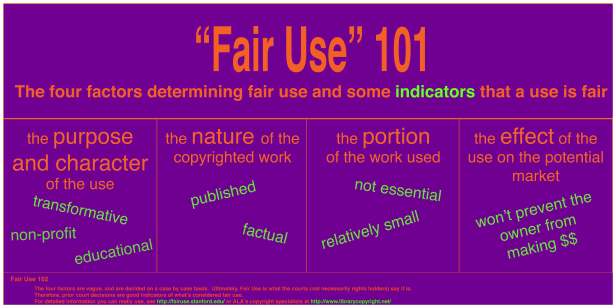

On comprend donc mieux ce qui s’est produit à propos de la chaîne MrDomainePublic. La personne qui la tenait, manifestement française au vu des sous-titres ajoutés au film, a pensé que Nosferatu était dans le domaine public, alors que ce n’est le cas qu’aux États-Unis. Ce site explique bien les différences de régime entre les USA et l’Europe à propos du domaine public :

Nosferatu est réputé appartenir au domaine public aux États-Unis. Cette oeuvre n’est donc plus soumise au droit d’auteur et peut être copiée et distribuée librement aux États-Unis. Certains sites américains, comme Internet Archive, bénéficient de ces circonstances et proposent des films du domaine public en téléchargement. Mais les utilisateurs allemands devraient à tout prix garder à l’esprit que la législation sur le domaine public peut ne pas être identique dans les pays européens. Ce qui est légal aux États-Unis peut avoir des conséquences fâcheuses ailleurs. Pour prendre un exemple : il est parfaitement possible qu’un film appartenant au domaine public soit toujours soumis au droit d’auteur dans un autre pays.

La Fondation Murnau a donc pu demander le retrait sur la base des droits toujours valides en Europe. On ne sait pas quelle version le propriétaire de la chaîne a mis en ligne, mais s’il s’agissait de la restauration de 2005, peut-être la Fondation Murnau a-t-elle revendiqué également des droits voisins en plus des droits d’auteur, bien qu’il soit douteux qu’une simple opération de numérisation puisse suffire à faire renaître des droits.

Nous n’avons donc pas ici affaire à un copyfraud, c’est-à-dire à une revendication abusive droits sur une oeuvre qui serait entrée dans le domaine public. Néanmoins, la manière dont la Fondation Murnau a agi n’en reste pas moins hautement critiquable quand on se replonge dans l’histoire de Nosferatu le vampire.

Comment Nosferatu a déjà failli disparaître à cause du droit d’auteur…

Nosferatu le vampire a une histoire très particulière, tenant au fait que que Murnau et le producteur du film, Albin grau, ont été poursuivis pour plagiat par la veuve de Bram Stoker, l’auteur de Dracula, ce qui a failli conduire à disparition complète du film. J’avais déjà raconté cette histoire dans un billet précédent sur S.I.Lex et ce qui est arrivé à la chaîne MrDomainePublic y fait furieusement penser :

Au début des années 20, le producteur du film, Albin Grau, souhaitait réaliser une adaptation du roman Dracula, mais il ne parvint pas à se faire céder les droits par la veuve de Bram Stoker, particulièrement dure en affaires. Le projet fut néanmoins maintenu, en introduisant des différences notables par rapport au roman, pour tenter d’échapper aux accusations de plagiat. Le lieu de l’action fut déplacé de Londres en Allemagne ; Dracula devint un Comte Orlock à l’apparence monstrueuse pour se démarquer du dandy victorien de Stoker et Murnau introduisit des détails absents du roman, comme le fait que la lumière du jour détruise les vampires. Comme le relève le site Techdirt, un certain nombre des traits que nous associons aujourd’hui naturellement aux vampires découlent en réalité de la nécessité pour Murnau d’éviter une condamnation pour violation du droit d’auteur !

Malgré ces précautions, le film fut attaqué en justice avec succès en Allemagne par la veuve de Stoker en 1925. La condamnation entraina la faillite de Prana Films, la société d’Albin Grau et la destruction de la plupart des copies et négatifs du film, ordonnée par les juges. La veuve de Stoker poursuivit de son côté une traque impitoyable de la moindre copie en circulation. L’histoire aurait pu s’arrêter là si une bobine n’avait pas miraculeusement survécu et été emportée aux Etats-Unis, où à cause d’une erreur d’enregistrement, le roman Dracula était déjà tombé dans le domaine public. La veuve de Stoker ne pouvant empêcher la diffusion dans ce pays, le film Nosferatu y connut le succès, jusqu’à ce que dans les années 60, il put revenir en Europe, lorsque les droit sur Dracula s’éteignirent.

Il est donc particulièrement cocasse de voir aujourd’hui la Fondation Murnau s’en prendre à cette chaîne sur YouTube, qui voulait rendre hommage au film Nosferatu le vampire, alors que celui-ci a failli disparaître à cause d’une querelle relative au droit d’auteur et qu’il n’a pu être sauvé que grâce au domaine public. Est-ce vraiment honorer la mémoire de Murnau que d’utiliser ainsi le droit d’auteur et qu’aurait-il voulu lui-même, sachant les épreuves qu’il a dû traverser ? On se demande aussi pourquoi la fondation a décidé de s’en prendre spécialement à la chaîne MrDomainePublic, alors que les vidéos de Nosferatu pullulent sur Youtube, qu’il s’agisse du film original ou de remix comme celui-ci :

Faire en sorte que le domaine public cinématographique existe réellement

Cette histoire édifiante montre que le domaine public est sans doute encore plus fragile en matière de cinéma que dans les autres champs de la création. Alors que j’écris ces lignes à propos de Nosferatu, le site Romaine lubrique a consacré un billet intéressant au cas du film La vie est belle de Franck Capra, qui semble lui aussi avoir bien du mal à reposer en paix dans le domaine public…

Le calcul des droits sur ce type d’oeuvres faisant intervenir de nombreux acteurs est redoutablement complexe, si bien qu’il est difficile de déterminer avec précision quand un film entre vraiment dans le domaine public. Même lorsque les questions de droits d’auteur ont été démêlées, il faut aussi prendre en compte les droits voisins qui portent sur les enregistrements et il peut s’avérer très compliqué de savoir si des droits sont encore attachés à telle ou telle version.

On se dit qu’un moyen de remédier à ces difficultés serait que des institutions publiques, chargées de conserver le patrimoine audiovisuel (on songe en France au CNC, à l’INA ou à la BnF) pourraient avoir dans leurs missions de certifier l’appartenance au domaine public des films et de proposer des versions réellement dans le domaine public, libres de droits voisins. La proposition de loi relative au domaine public déposée par Isabelle Attard contient l’idée de mettre en place un Registre du domaine public en France, qui pourrait avoir cette fonction.

En attendant le beau projet de curation que constituait la chaîne MrDomainePublic a fait les frais de ces incertitudes juridiques liées à la complexité du statut du domaine public, ainsi que de l’étrange "‘amnésie" de la Fondation Murnau quant à l’histoire de Nosferatu le Vampire…

Classé dans:Domaine public, patrimoine commun Tagged: cinéma, copyfraud, Domaine public, droit d'auteur, droits voisins, films, Murnau, nosferatu, Vampire, youtube