Rebooter le web sans changer de logiciel économique ?

mardi 9 octobre 2018 à 07:54Il y a dix jours, Tim Berners-Lee a publié un billet intitulé « One Small Step for the Web » dans lequel il annonce qu’il se met en retrait de ses fonctions au W3C. Il y déclare avoir pris cette décision pour consacrer l’essentiel de son temps au projet Solid (Social Linked Data) qu’il développe depuis plusieurs années en nourrissant l’espoir de rebooter le web sur de nouvelles bases plus saines. Cette annonce fait suite à une interview donnée cet été à Vanity Fair, dans laquelle Tim Bernes-Lee se disait « effondré » face au constat que « le web a desservi l’humanité au lieu de la servir » :

Nous avons démontré que le Web avait échoué au lieu de servir l’humanité, comme il était censé le faire, et qu’il avait échoué par de nombreux aspects. La centralisation croissante du Web, dit-il, a fini par produire – sans volonté délibérée de ceux qui l’ont conçu – un phénomène émergent à grande échelle qui est anti-humain.

Je pense que Tim Berners-Lee a très mûrement pesé ses mots en choisissant le qualificatif « d’anti-humain », dans le sens où il estime que les maux liés à la centralisation sur les grandes plateformes – l’exploitation abusive des données personnelles, les atteintes à la vie privée, la manipulation des informations type fake news ou la surveillance étatique de masse – sont si graves qu’ils nous font littéralement perdre une part de notre humanité.

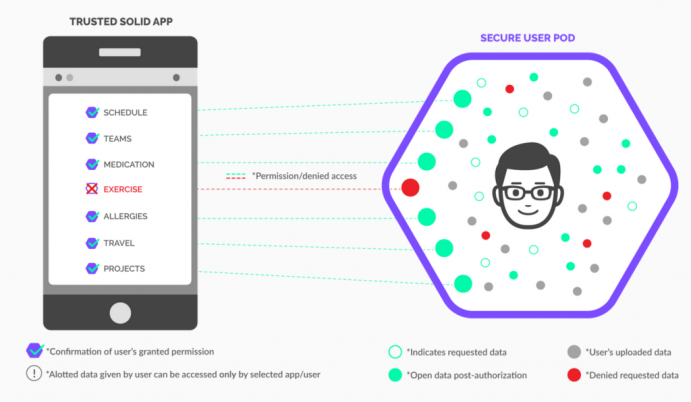

Pour lutter contre cette tendance à la centralisation, le projet Solid cherche à créer un nouveau standard qui permette de «séparer les données des applications et des serveurs qui les utilisent». Chaque individu pourrait ainsi reprendre le contrôle sur ses données à partir d’un POD (Personal Online Data) : un espace souverain dans lequel les données sont stockées et auquel les applications tierces viendraient s’interfacer en évitant que les informations soient accumulées dans des « silos », comme c’est le cas actuellement avec les GAFAM. Solid ressemble donc à des projets comme Cozy Cloud, par exemple, à la différence qu’il ajoute à l’hébergement personnel des données une couche de web sémantique pour offrir un standard d’interopérabilité entre les différentes applications, d’où la dénomination de Social Linked Data (données sociales liées).

En mode Start-up et capital-risque ?

Sur le fond, on peut se réjouir de voir une personnalité comme Tim Berners-Lee ne pas se résigner à la domination des grandes plateformes, que beaucoup se contentent aujourd’hui de chercher à « réparer » en compensant les dégâts humains considérables qu’elles produisent, par exemple en prônant des solutions comme l’ouverture de leurs algorithmes. Mais j’avoue avoir reçu une douche froide en lisant que si Tim Berners-Lee avait mis en veille ses fonctions au W3C, c’était en réalité pour s’investir dans la société Incept, qu’il présente lui-même comme une « start-up » :

Il faudra beaucoup d’efforts pour construire une nouvelle plateforme pour Solid et favoriser son adoption à grande échelle, mais je pense que nous avons assez d’énergie pour amener le monde à un nouveau point de bascule.

J’ai donc pris un congé sabbatique du MIT, j’ai réduit mon implication quotidienne avec le World Wide Web Consortium (W3C) et j’ai fondé une société appelée inrupt où je vais guider la prochaine étape du web de manière très directe. Inrupt sera l’infrastructure qui permettra à Solid de prospérer. Sa mission est de fournir l’énergie commerciale et un écosystème pour aider à protéger l’intégrité et la qualité du nouveau web basé sur Solid.

Il existe de nombreux exemples dans le domaine de l’open-source qui ont énormément bénéficié de la contribution d’une entreprise bien financée. Alors que la communauté open-source est source d’initiative et d’innovation, les internautes de tous les jours et les entreprises recherchent souvent des applications et des services auprès d’une entité commerciale qui fournit également un soutien technique et des services commerciaux auxiliaires essentiels.

Quand on cherche un peu, on se rend compte qu’Incept a été financée par Union Square Ventures, un pourvoyeur de capital-risque ayant apporté des fonds à des initiatives « alternatives » comme DuckDuckGo, mais possédant aussi des parts dans Foursquare, KickStarter ou même Twitter. Or ce montage financier pose question et aussi pertinente que puisse être la solution technique proposée par Solid, on peut déplorer que Tim Berners-Lee cherche ainsi à rebooter le web sans changer le « logiciel économique » qui a joué un rôle pourtant prééminent dans les dérives qu’il souhaite combattre.

Dans un billet ironiquement intitulé «Solid Venture», le développeur Bob Mottram fait part de ses doutes quant à cette implication de la société Incept dans le projet, en faisant valoir que, contrairement à ce que dit Tim Berners-Lee, la synergie entre Open Source et entreprises classiques n’est pas « neutre » et qu’elle a pu conduire dans le passé à des dérives :

J’ai de la sympathie pour tout ce qui tente de redécentraliser le web et de le remettre dans un état où tout le monde ne se retrouve pas enfermé une poignée de bases de données, comme cela s’est passé avec le web 2.0. Mais être soutenu par du capital-risque n’est pas un bon signe. Chercher à produire du code public avec du capital-risque semble toujours déboucher sur l’un des deux résultats suivants :

- L’entreprise échoue et le projet devient abandonware ;

- L’entreprise réussit et les utilisateurs des logiciels se retrouvent piégés par un arrangement commercial très artificiel et généralement désagréable qu’ils détestent.

[…]

Dans la sphère des logiciels, la dépendance au capital-risque aboutit généralement à des stratégies qui forcent les gens à souscrire des abonnements ou à des revirements de licence dans le sens de la propriétarisation ou encore à adopter le modèle de « l’open core » dans lequel la base du code est laissée ouverte, mais réduite à un croupion inutile, tandis que tout ce qui a de la valeur prend la forme de modules complémentaires ou de versions destinées au marché des entreprises. Ou bien vous finissez simplement par vous vendre à Microsoft et à Google et ils vous arrêtent pour supprimer un concurrent potentiel à leurs produits. Cela s’est produit bien des fois

Et c’est bien ce qui pose problème avec l’initiative de Tim Berners-Lee. Si Solid vient à rencontrer du succès (ce que l’on peut souhaiter), qu’est-ce qui nous garantit que la société Incept ne changera pas brutalement de modèle (comme Twitter l’a par exemple fait en 2009) ? La présence de Tim Berners-Lee à son board constitue-t-elle à elle seule une sécurité suffisante ? Il faudrait être bien naïf pour le croire, car tout inventeur du web qu’il est, il peut très bien se faire mettre en minorité au sein de sa propre structure et il n’est pas non plus immortel. Le risque d’un rachat par un des grands Leviathans du web comme Apple, Google ou Facebook n’est donc pas une hypothèse à écarter comme fantasmatique (NB : la même question se pose d’ailleurs aussi avec un acteur comme Qwant, alternatif dans son modèle économique et son objectif de protéger la vie privée de ses utilisateurs, mais tout à fait classique dans la structure de son capital…).

Conception « enchantée » du marché

Cette volonté de chercher à refonder le web en mode « start-up » me paraît relever d’une conception « enchantée » du marché et de la concurrence, comme si les puissances économiques qui ont fait naître les plateformes toxiques avec lesquelles nous nous débattons n’allaient pas être en mesure de trouver le moyen d’adultérer une initiative comme Solid en cas de succès. Ce n’est pas un hasard si la « plateformisation » du web, qui est intervenue au milieu des années 2000 avec la vague du Web 2.0, a coïncidé avec la montée en puissance de la financiarisation de l’économie. Certes, aucune entreprise n’est éternelle et la concurrence peut amener la chute de géants que l’on croyait bien établis. Mais pour l’instant, cette dynamique « schumpétérienne » du marché nous a-t-elle apporté autre chose que du pire, car si MySpace et Yahoo ont fini par péricliter, c’est pour que Facebook et Google les remplacent !

Solid semble de ce point de vue reposer en partie sur le « solutionnisme technologique » dénoncé par l’essayiste Evgueny Morozov, qui pousse à croire qu’un Deus Ex Machina pourrait encore nous sauver sans prendre en compte les sur-déterminations économiques de la tendance à la centralisation. C’est pourtant une chose que le juriste Eben Moglen, l’un des pères avec Richard Stallman de la GNU-GPL, avait parfaitement pointé dès 2010 :

Si les services se centralisent, c’est pour des raisons commerciales. Il y a dans un simple historique de navigateur Web un potentiel qui est monétisable, parce qu’il fournit le moyen de mettre en place une forme de surveillance, attrayante tant pour les marchands que pour les gouvernements pour le contrôle social qu’elle permet. Ainsi le web, lorsqu’il s’appuie sur une architecture essentiellement basée sur le système client-serveur, devient un dispositif de surveillance au-delà des services qu’il fournit. Et la surveillance devient cette fonctionnalité cachée à l’intérieur de tout ce que nous recevons gratuitement.

Ce qui s’est (mal) passé avec le web sémantique…

Alors certes, le projet Solid est intrinsèquement conçu pour éviter l’exploitation des données personnelles, son code a été placé en Open Source et il s’appuie sur les technologies du web sémantique pensées pour prévenir la concentration des données dans des silos fermés. Mais le destin même du web sémantique devrait nous alarmer, car comme le montre bien Gautier Poupeau dans un billet publié sur son blog cette semaine, il n’a pas été non plus épargné ces dernières années par la tendance à la centralisation, notamment avec la place centrale prise peu à peu par le projet Wikidata :

Les objectifs initiaux de Wikidata ont été rapidement dépassés, car ce projet répondait à de nombreux défauts des autres projets existants en la matière. Par rapport à Dbpedia, il présentait l’avantage d’être mis à jour en temps réel (Dbpedia est mis à jour tous les 6 mois…), d’offrir une qualité de service bien supérieure et de proposer une structuration des données plus rigoureuse, dbpedia étant issu de données dont l’objectif n’était pas celui d’alimenter une base de données structurées à l’origine. Comparé à Freebase, initiative lancée par la société Metaweb rachetée par Google en 2010, ce projet présentait l’avantage d’être porté par une communauté libre clairement établie. Bref, Wikidata est devenu LE projet de base de connaissances libre et ouvert que tout le monde attendait : le chaînon manquant de la gestion des connaissances. […]

Ironie de l’histoire, alors que le Linked Open Data souhaitait mettre en relation des données hétérogènes et décentralisées chez différents fournisseurs, il aura suffi de 5 ans pour que les utilisateurs commencent à recentraliser leurs données au sein d’un espace unique.

Wikidata est porté par la fondation Wikimedia (qui n’a pas de but lucratif) et on pourrait donc penser que ce retour de la centralisation n’est pas lié à des déterminations économiques. Mais Gautier Poupeau explique que cette re-centralisation du web sémantique tient essentiellement à la manière dont un acteur comme Google est parvenu à instrumentaliser cette technologie :

[…] pour vous convaincre de l’importance de ce projet, il suffit de voir l’implication de Google : mécène du projet à l’origine, ils ont recruté son développeur principal, Denny Vrandečić, lorsque le projet a été stabilisé. Et pour cause : grâce au rachat de la société Metaweb, Google a disposé non seulement d’une technologie de graphe scalable (qui ne suivait pas non plus précisément le modèle RDF…) mais aussi d’une base de connaissances déjà conséquente. C’est sur cette base que Google a commencé à construire le Knowledge graph, un autre exemple de base de connaissances centralisé bâti sur le modèle de graphe sans utiliser RDF. Ils ont rapidement compris qu’ils ne pourraient convaincre la communauté de poursuivre l’alimentation de Freebase, car cela revenait à travailler directement pour eux. Ils ont donc intelligemment proposé de reverser le contenu de Freebase dans Wikidata et ils ont accompagné la mise en place de Wikidata. Permettre l’éclosion de Wikidata, c’était aussi pour Google un moyen d’assurer une mise à jour de son graphe de connaissance, même si bien évidemment Wikidata n’est pas la seule source de ce knowledge graph.

[…] Tout ça pour ça ? Permettre aux moteurs de recherche de récupérer plus facilement de la donnée structurée pour améliorer la visibilité des résultats de recherche (et surtout leur permettre d’alimenter leur knowledge graph à moindre frais…).

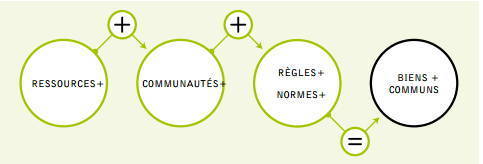

Tout ceci n’est pas sans lien avec ce que j’écrivais en juin dernier à propos de la tendance des Communs numériques à dégénérer au fil du temps en « Communs du Capital ». Certes un projet comme Wikidata ne peut être « racheté » par un acteur comme Google pour en faire sa propriété exclusive. Mais même lorsque des ressources sont ainsi rendues « inappropriables », on assiste souvent à ce que Michael Hardt appelle dans un article récent une « extraction du Commun », processus qu’il décrit comme étant le « paradigme du capital ». Revisitant la notion marxiste de « subsomption sous le capital », il explique comment le système parvient généralement à satelliser ce qu’il ne peut directement avaler.

Faute d’un recul suffisant sur ces tendances structurantes dans l’environnement numérique, le projet Solid paraît donc d’emblée mal engagé. Via la société Incept, il offre une proie facile au Capital, tandis que les technologies du web sémantique sur lesquels il s’appuie sont déjà travaillées par un processus de recentralisation, en raison de puissantes sur-déterminations économiques.

Qui savait au début qu’il y aurait une fin ?

Avons-nous réellement envie de suivre Tim Berners-Lee sur le chemin qu’il nous propose ? Ne peut-on déjà prévoir à ce reboot du web une fin similaire à celle que le premier web a subi ? Il y a dans cette démarche une certaine naïveté qui fait penser à ces écologistes croyant encore que la planète pourra être sauvée sans remettre en cause en profondeur les principes de l’économie de marché. Car tout comme l’Anthropocène est en réalité un Capitalocène, la centralisation du web n’est pas un processus « naturel » ou inhérent à une mystérieuse « nature de l’homme » ou des choses. C’est un stade de l’histoire du Capital, que certains désignent à juste titre par le vocable de «capitalisme de surveillance».

Tim Berners-Lee paraît de ce point de vue assez représentatif de certaines errances de la pensée du Libre et de l’Open. Cela tient à ce que j’appelle « l’agnosticisme économique » de ce courant de pensée, qui n’a jamais été capable de pousser jusqu’au bout sa critique de l’économie de marché. Le temps des synergies décrites initialement comme « heureuses » entre Open Source et entreprises paraît à présent bien loin et ce n’est plus uniquement sur la couche technique des standards qu’il faut agir pour espérer une refondation d’internet. C’est à mon sens à présent du côté des réflexions sur la convergence entre les Communs numériques et l’économie solidaire qu’il faut se tourner pour trouver des modèles qui – tout en s’inscrivant dans la sphère économique – pensent d’emblée la limitation de la lucrativité et le réencastrement des acteurs de marché dans des finalités sociales.