Le non commercial, avenir de la culture libre

jeudi 18 octobre 2012 à 11:01

Depuis le mois d’avril 2012, la fondation Creative Commons International a annoncé qu’une nouvelle version de ses licences (la 4.0) allait être publiée et un appel à commentaires a été lancé pour inviter la communauté à participer à la réflexion.

Des modifications importantes sont envisagées, comme le fait de globaliser les licences pour ne plus avoir à les adapter pays par pays, en fonction des législations nationales. Mais c’est une autre question qui s’est imposée dans les discussions : celle de la conservation ou non de la clause Non Commercial – Pas d’Utilisation Commerciale (NC).

Il s’agit à vrai dire d’un vieux débat qui divise le monde du libre depuis des années. A la différence des licences libres ou Open Source nées dans le secteur du logiciel, les licences Creative Commons proposent à leurs utilisateurs une option pour autoriser la réutilisation de leurs oeuvres, tout en maintenant l’interdiction de l’usage commercial.

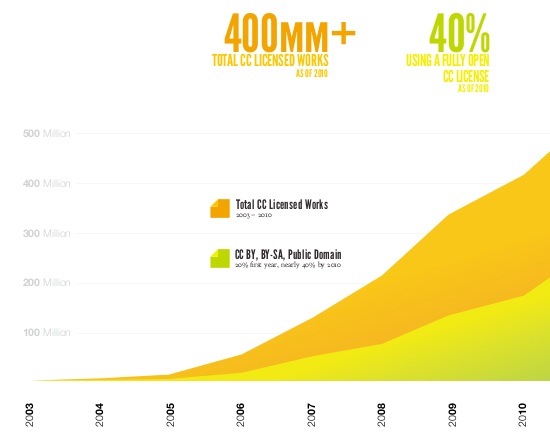

Si l’on en croît le graphique ci-dessous, publié par Creative Commons dans la brochure The Power of Open, l’option NC est retenue par une majorité d’utilisateurs : 60% sur les quelques 450 millions d’oeuvres placées sous licence Creative Commons. Si l’on observe un site comme Flickr, la plateforme de partage de photographies, la tendance est plus forte encore : sur les 240 millions de photos sous licence Creative Commons que contient Flickr, 170 millions comportent une clause Non Commercial, soit 71%.

En dépit de cette large adoption, le monde du libre est agité de débats pour savoir si de telles clauses sont compatibles avec les exigences de la Culture libre et si elles ne devraient pas tout simplement être supprimées des choix offerts par les licences Creative Commons.

Quand les licences Creative Commons ont commencé à devenir visibles, la communauté du libre, familiarisée avec les problématiques du logiciel, a fraîchement accueilli ces clauses NC. Une partie de la communauté a alors considéré que les licences interdisant les usages commerciaux ne devaient pas être considérées comme des licences “libres”. Une autre appellation a été mise en place pour les distinguer, celle de licences “de libre diffusion”.

Un label spécial a même été établi – et accepté par Creative Commons International – celui “d’oeuvre culturelle libre“, proche des quatre libertés du logiciel libre, accordé seulement à certaines licences parmi celles que propose Creative Commons : la CC-BY (Attribution), la CC-BY-SA (Attribution – Partage dans les mêmes conditions, qui est la licence de Wikipédia) et la CC0 (versement volontaire au domaine public).

Beaucoup de critiques adressés à la clause non commerciale portent sur son imprécision et il est vrai que la formulation actuelle des licences peut paraître ambigüe :

L’Acceptant ne peut exercer aucun des droits qui lui ont été accordés à l’article 3 d’une manière telle qu’il aurait l’intention première ou l’objectif d’obtenir un avantage commercial ou une compensation financière privée. L’échange de l’Œuvre avec d’autres œuvres soumises au droit de la propriété littéraire et artistique par voie de partage de fichiers numériques ou autrement ne sera pas considérée comme ayant l’intention première ou l’objectif d’obtenir un avantage commercial ou une compensation financière privée, à condition qu’il n’y ait aucun paiement d’une compensation financière en connexion avec l’échange des œuvres soumises au droit de la propriété littéraire et artistique.

Qu’est-ce exactement qu’un “avantage commercial” ou une “compensation financière privée” ? Le “non-commercial” est défini de manière à inclure le partage non-marchand de fichiers, mais la délimitation avec les activités commerciales reste incertaine. Conscient du problème, Creative Commons avait publié en 2009 un rapport sur la question, soulignant la difficulté à tracer la distinction entre commercial et non commercial, mais sans apporter de réelles solutions.

Pour la version 4.0, l’intention de départ sur ce point était seulement d’essayer de clarifier la définition du NC, mais le débat a dévié vers l’opportunité de supprimer purement et simplement l’option. Plusieurs voix importantes se sont élevées pour réclamer cette réforme, comme celle de Rufus Pollock, l’un des co-fondateurs de l’Open Knowledge Foundation. Il soutient notamment que la clause non-commerciale est incompatible avec la notion de biens communs.

En France, Framablog s’est fait l’écho de ces débats, en publiant une série de traductions en défaveur de la clause non-commerciale (1, 2, 3), suivi par Stéphane Bortzmeyer sur son blog.

A contrecourant de ce pilonnage en règle, je voudrais ici montrer que la suppression de la clause non-commerciale serait une très mauvaise idée pour la défense de la Culture libre. La notion de “non-commercial” revêt même une importance stratégique décisive pour l’avenir, dans la mesure où, au-delà des licences Creative Commons, elle sert de pivot aux grands projets globaux de réforme du système de la propriété intellectuelle.

Plutôt que de la saper, les communautés du libre devraient plutôt contribuer à la réflexion pour la rendre la plus opérationnelle possible. C’est l’avenir de la réforme du droit d’auteur qui passera par le non-commercial (ou ne passera pas…).

Le faux argument du flou juridique

Le principal argument employé contre la clause “non commercial” réside dans le fait que la notion serait floue et qu’elle génèrerait de fait une insécurité juridique trop importante. Tous les détracteurs mettent en avant l’imprécision dans leur critique et on la retrouve notamment chez Eric Raymond, repris sur Framablog :

Ce pourquoi elle devrait être enlevée n’a rien à voir avec aucune profonde philosophie ou politique couramment apportées dans le débat, et tout à voir avec le fait qu’il n’y a pas de critère légal de démarcation pour “activité commerciale”. Cette mauvaise définition se reflète dans les débats pour le terme commercial, qui signifie transaction financière ou lucratif, et c’est l’exacte raison pour laquelle l’Open Source Definition interdit aux licences logicielles open source de disposer de restrictions similaires.

Le groupe fondateur de l’OSI, après avoir étudié la possibilité, a conclu que l’attribut “NC” au sein d’une licence open source créerait une trop grande confusion au regard des droits et obligations, de trop nombreux effets secondaires sur des comportements que nous ne souhaitons pas encourager, et trop d’ouvertures possibles pour les plaideurs compulsifs. Ce qui est uniquement une source de contentieux au sein de notre communauté pourrait se révéler destructeur pour elle si des tribunaux antipathiques venaient à prendre des décisions défavorables, même de faible portée.

La première chose que l’on peut relever, c’est que le risque évoqué des “plaideurs compulsifs” ne s’est pas réalisé, depuis 10 ans bientôt qu’existent les licences Creative Commons.

Les procès ont été très rares (il n’y en a même aucun encore en France à propos des CC). Un certain nombre d’affaires cependant peuvent être citées ailleurs dans le monde, dans lesquelles les juges ont reconnu à chaque fois la validité des licences Creative Commons, lorsque des auteurs ont réclamé le respect des conditions qu’ils avaient fixées (pas du tout des plaideurs compulsifs donc, mais un usage “normal” et légitime des contrats que sont les Creative Commons).

Or plusieurs fois, les auteurs se plaignaient qu’un usage commercial avait été réalisé de leur oeuvres, alors qu’ils avaient fait le choix de les interdire par le biais d’une clause NC. Ce fut le cas en 2006 aux Pays-Bas (vente de photos par un magazine), en 2009 en Israël (photographies postées sur Flickr revendues incorporées à des collages), en 2009 encore en Belgique (reprise d’une musique dans une publicité pour un théâtre). Dans les trois cas, les juges n’ont eu aucune difficulté à établir que la clause NC avait été violée et les décisions n’ont pas fait l’objet d’un appel. Pas si mal, non, pour une clause jugée irréparablement imprécise !

La soi-disant imprécision du NC n’est en fait que relativement limitée. Il est vrai qu’elle affecte certains points importants : le fait de reprendre une oeuvre sur un site générant des revenus par le biais de publicités par exemple, ou encore celui d’utiliser une oeuvre dans un contexte pédagogique impliquant des échanges financiers (cours payant, formateur rémunéré, etc).

Mais pour l’essentiel, la définition du NC est largement opératoire. Un exemple intéressant à citer à ce propos réside dans le billet Complexité de la clause Non Commerciale des licences Creative Commons : la preuve par l’exemple, écrit par Evan Podromou et traduit par Framablog.

L’auteur liste une longue série de cas d’usages et essaie de montrer par ce biais l’imprécision de la clause NC. Mais il se trouve qu’en réalité, Evan Podromou apporte exactement la preuve inverse de celle qu’il voulait donner : dans la majorité des cas, il est capable de déterminer avec une certitude suffisante comment la clause doit être appliquée. Ce n’est que dans des hypothèses improbables et tarabiscotées que la clause est prise en défaut. Sur l’essentiel, elle tient largement la route :

- Un éditeur télécharge un livre sous licence CC by-nc 2.0 sur internet, en fait un tirage de 100 000 exemplaires et le vend en librairies dans le pays. (Non)

- Un particulier télécharge un livre sous licence CC by-nc 2.0 sur son ordinateur et le lit. (Oui)

- Un particulier télécharge un livre sous licence CC by-nc 2.0 sur son ordinateur, l’imprime sur son imprimante, et lit le document imprimé. (Oui)

- Un particulier télécharge un livre sous licence CC by-nc 2.0 sur son ordinateur et l’envoie par courriel à un ami. (Oui)

- … et le partage avec le monde sur son site web. (Oui)

- … et le partage avec le monde via un réseau P2P. (Oui)

- Un particulier télécharge un livre sous licence CC by-nc 2.0 sur son ordinateur, l’imprime sur son imprimante et le donne à un ami. (Oui)

Après ça, je veux bien que l’on soutienne que l’idéologie ou la philosophie ne jouent aucun rôle dans le rejet de la clause NC, mais il me semble au contraire que l’idéologie a beaucoup de choses à voir avec la manière dont certains l’appréhendent, alors qu’une analyse juridique objective aboutit à de toutes autres conclusions.

Mettre en avant le flou juridique pour rejeter une notion, c’est aussi méconnaître profondément la manière dont fonctionne le droit lui-même. Le droit en réalité n’est jamais une matière “en noir et blanc”, même quand il utilise des catégories binaires. Il est rempli de “zones grises”, qui sont autant de marges de manoeuvre laissées aux juges pour adapter la règle de droit à la réalité, toujours mouvante.

Didier Frochot explique très bien sur le site les Infostratèges que ces zones grises du droit jouent en fait un rôle fondamental pour l’équilibre du système :

Les zones grises sont une inévitable conséquence du fait que le droit est une science humaine : rêver de supprimer ces zones reviendrait à enfermer les êtres humains dans ces règles strictes et à leur interdire de vivre et d’évoluer. C’est peut-être le cas sous des régimes autoritaires dans lesquels peu de place est laissée à la liberté de l’homme, mais dans des pays libres, c’est la rançon du respect des libertés fondamentales.

Dans les pays respectueux des libertés donc, le couple droit écrit — jurisprudence est là pour définir les grands principes par écrit et délimiter la frontière au coup par coup et à mesure de l’évolution de la société, afin de réduire le plus possible ces fameuses zones grises.

Frochot rappelle aussi que beaucoup de notions juridiques comportent une marge d’incertitude quant à leur application (l’originalité, la vie privée, la diffamation, l’injure, etc). Faut-il pour autant les supprimer ? Il ne resterait plus grand chose dans les Codes ! Et d’ajouter cet argument essentiel :

Mieux vaut considérer la vérité statistique : dans la majeure partie des cas, on sait précisément de quel côté de la frontière juridique on se trouve.

C’est le cas pour la clause NC, comme le démontre justement l’article de Framablog cité ci-dessus.

Par ailleurs, remarquons que les tenants de la suppression de la clause NC sont en général de farouches défenseurs du Partage à l’identique (Share Alike ou SA), autre option des licences Creative Commons. Or les effets de cette dernière sont tout aussi difficiles à déterminer, sinon davantage.

Un exemple éclatant en avait été donné lors de l’affaire Houellebecq contre Wikipédia, lorsque l’écrivain Michel Houellebecq avait été accusé d’avoir plagié des articles de Wikipédia en incorporant des extraits dans son roman sans citer la source. Les avis s’étaient partagés sur le point de savoir si l’effet viral de la licence CC-BY-SA de Wikipédia s’était déclenché à l’occasion d’une telle incorporation. Impossible de le déterminer : seul un juge en définitive aurait pu trancher avec certitude la question.

Supprimer la clause NC parce qu’elle est trop imprécise, pourquoi pas ? Mais si l’imprécision est la véritable raison, il faudrait aussi supprimer la clause SA !

Toutes les oeuvres ne sont pas des logiciels

Une source de confusions dans ce débat réside dans le fait que les détracteurs de la clause NC sont en général issus de la communauté du logiciel libre et ils restent fortement imprégnés de la logique particulière de ce domaine. Mais cette dernière n’est pas généralisable à l’ensemble des champs de la création, dans la mesure où toutes les oeuvres ne sont pas assimilables à des logiciels.

Dans le domaine du logiciel libre, la clause de Partage à l’identique (SA) joue en effet un rôle important de régulation, dans la mesure où elle se déclenche fréquemment en cas de réutilisation de l’oeuvre. En effet, lorsqu’un réutilisateur modifie une oeuvre pour en produire une nouvelle, la clause SA s’applique et l’oblige à placer l’oeuvre dérivée sous la même licence (effet viral). Dans le cas d’un logiciel, la clause se déclenche fréquemment lors d’une réutilisation, car pour utiliser un logiciel dans un autre contexte que celui d’origine, il est souvent nécessaire d’adapter le code. Cela induit un rapport particulier être les communautés développant les logiciels libres et le secteur marchand, évitant que leurs créations soient réappropriées de manière exclusive. C’est aussi le cas pour les wikis, où l’usage même implique une modification, ce qui fait que la licence CC-BY-SA convient très bien à Wikipédia.

Mais pour les oeuvres non-logicielles, les hypothèses de déclenchement de la clause SA sont plus rares. L’auteur d’un roman par exemple ne pourra pas empêcher que son oeuvre soit vendue, telle quelle par un éditeur s’il la place simplement sous licence BY-SA. Pour la photographie, c’est encore plus le cas. Les photos peuvent facilement être réutilisées sans modification, comme illustrations. Dans cette hypothèse, le partage à l’identique ne se déclenche pas.

Le problème, c’est que lorsqu’on examine les modèles économiques des acteurs qui utilisent les licences Creative Commons, on constate que dans bien des situations, ils reposent sur la réservation de l’usage commercial. Pour un auteur de textes par exemple, il arrive que des éditeurs acceptent que des oeuvres soient publiées par leur soin en papier, tout en permettant que les versions numériques circulent en ligne sous licence Creative Commons. Mais cette hypothèse est déjà rare (tout le monde n’est pas aussi militant que Framabook !) et elle le serait encore davantage, s’il n’était pas possible de réserver les usages commerciaux avec des licences NC.

Il existe également des photographes (Trey Ratcliff, Jonathan Worth), qui font le choix de diffuser leurs clichés sur Internet sous licence Creative Commons. Ils utilisent les forces du partage pour gagner en notoriété et faire connaître leurs oeuvres. Mais leur modèle économique repose sur la possibilité de continuer à tarifier les usages commerciaux, qu’il s’agisse de publications dans des médias ou d’expositions. On peut supprimer la clause NC, mais quel modèle économique pourra alors être mis en place dans le champ de la photo, hormis peut-être le crowdfunding ?

Toutes les oeuvres ne sont pas des logiciels et certains secteurs ont besoin de la clause NC pour que se constitue une économie du partage.

Défendre le non commercial, au lieu de le dénigrer

Le problème de la clause NC n’est pas tant l’imprécision que la généralité et on peut reprocher à Creative Commons International de ne pas avoir fait suffisamment de choix concernant la définition.

Car il serait assez simple en définitive de trancher une fois pour toutes les incertitudes affectant la notion. La discussion sur le site de Creative Commons à propos du passage à la version 4.0 est instructive à cet égard. 12 propositions avaient été faites dont certaines auraient pu apporter de réelles améliorations. Par exemple, préciser explicitement si la diffusion sur un site comportant de la publicité est un usage commercial ou non. Ou déterminer si un usage pédagogique doit être considéré ou non comme non-commercial, même s’il implique des échanges monétaires.

Mais pour cela, il aurait fallu que la communauté Creative Commons soit en mesure de choisir et il semble que ce soit davantage ce problème de gouvernance qui bloque l’évolution de la définition de la clause NC. La fondation Creative Commons s’oriente visiblement vers un maintien en l’état de la clause NC, ce qui ne manquera de faire grincer des dents, mais paraît l’option la plus sage, faute de consensus.

D’autres propositions intéressantes sont sur la table. Dans ce billet traduit en français par Paul Netze sur son site Politique du Netz, Rick Falkvinge du Parti Pirate Suédois propose une autre forme de définition, orientée vers la nature de la personne en cause :

En définissant l’usage commercial comme un “usage par une entité légale qui n’est pas une personne naturelle ou une association à but non-lucratif”, vous l’appliquez uniquement aux entreprises à but lucratif. Vous permettez aux particuliers de vendre des disques à la sauvette au pied du camion, mais vous évitez les arnaques à grande échelle qui se règlent désormais dans les salons feutrés des cabinets d’avocat. Vous permettez aux gens de partager pour autant que cela n’équivaut pas à un emploi dans une entreprise. C’est la meilleure définition que j’ai vue jusqu’ici.

C’est une approche “organique”, mais on peut en concevoir d’autres d’ordre “matériel”, comme de réduire strictement le commercial à la vente du contenu. On peut aussi procéder de manière téléologique en définissant le commercial par le but lucratif.

Toutes ces hypothèses sont ouvertes, mais encore faudrait-il choisir !

L’important cependant, c’est de défendre le non-commercial contre les tentatives majeures de distorsion qu’il pourrait subir. Ce fut le cas notamment avec l’accord passé l’an dernier entre la SACEM et Creative Commons. La SACEM a accepté que ses membres puissent placer certaines des oeuvres de leur répertoire sous CC. Elle limite cependant cette option aux licences CC comportant la clause NC, ce qui me paraît compréhensible étant donné la nature de l’acteur. Mais à cette occasion, la définition du non-commercial a été modifiée à la demande la SACEM pour recouvrir un nombre important d’usages publics (par exemple, la simple diffusion dans un espace accessible au public). C’est une dérive grave et on ne devrait pas laisser évoluer ainsi la définition du non-commercial !

Mais pour cela, il faudrait que les communautés du libre participent à la défense du non-commercial face à ce genre d’agressions, plutôt que de le dénigrer systématiquement. D’autant plus que le non-commercial est appelé à jouer un rôle stratégique majeur pour l’avenir, au-delà de la question des licences.

Le non commercial, nouvelle frontière de la réforme du droit d’auteur ?

La notion de non-commercial joue en effet un rôle clé dans les propositions les plus élaborées actuellement pour penser la réforme du droit d’auteur. Les Éléments pour une réforme du droit d’auteur et les politiques culturelles liées, soutenus par la Quadrature du Net, s’articulent autour de la légalisation du partage non-marchand. Philippe Aigrain propose une définition volontairement restrictive du non-marchand, se rapprochant de l’usage personnel, afin d’éviter la centralisation des fichiers :

Constitue un partage entre individus toute transmission d’un fichier (par échange de supports, mise à disposition sur un blog ou sur un réseau pair à pair, envoi par email, etc.) d’un lieu de stockage “ appartenant à l’individu ” à un lieu de stockage “ appartenant à un autre individu ”. “ Appartenant à l’individu ” est évident quand il s’agit d’un ordinateur personnel, d’un disque personnel ou d’un smartphone. Mais cette notion recouvre aussi un espace de stockage sur un serveur, lorsque le contrôle de cet espace appartient à l’usager et à lui seul (espace d’un abonné d’un fournisseur d’accès sur les serveurs de ce FAI, hébergement cloud si le fournisseur n’a pas de contrôle sur le contenu de cet hébergement).

Un partage est non-marchand s’il ne donne lieu à un aucun revenu, direct ou indirect (par exemple revenu publicitaire) pour aucune des deux parties. La notion de revenu est à entendre au sens strict comme perception monétaire ou troc contre une marchandise. Le fait d’accéder gratuitement à un fichier représentant une œuvre qui fait par ailleurs l’objet d’un commerce ne constitue en aucun cas un revenu.

Un même rôle décisif est alloué au non-commercial dans le programme du Parti Pirate, dont on retrouve les grandes lignes dans l’ouvrage The Case For Copyright Reform, traduit à nouveau en français par Paul Netze.

Nous voulons que le droit d’auteur redevienne ce pourquoi il a été conçu, et rendre clair qu’il ne doit réguler que les échanges commerciaux. Copier ou utiliser un travail protégé sans but lucratif ne devrait jamais être interdit. Le pair à pair est, entre autres, une bonne raison pour cette légalisation.

Et les auteurs, Rick Falkvinge et Christian Engström, insistent sur le caractère globalement opérationnel de la distinction Commercial/Non commercial :

Nous possédons déjà un arsenal juridique qui fait la distinction entre intention commerciale et non commerciale, incluant la législation sur le droit d’auteur telle qu’elle existe aujourd’hui. C’est une bonne chose que les tribunaux aient déjà établi une jurisprudence afin de déterminer ce qui est commercial ou pas [...] de façon générale, la limite entre activité commerciale et non commerciale est grossièrement à l’endroit où vous vous y attendiez.

Même Richard Stallman, libriste parmi les libristes, admet dans son projet global de réforme du système que la notion de non-commercial joue un rôle, pour les oeuvres d’art ou de divertissement !

Pour qu’il connaisse une évolution en profondeur, le système du droit d’auteur a besoin d’une réforme de grande ampleur. Il est clair que les projets politiques les plus élaborés ont besoin de la distinction entre le commercial et le non-commercial. D’une certaine manière, il s’agit même de la nouvelle frontière à atteindre. Dénigrer le non-commercial, en soutenant que la notion est vicieuse, c’est saper les chances qu’une telle réforme advienne. Lourde responsabilité à assumer…

Les lois actuelles, conçues pour l’environnement analogique, fonctionnaient sur la distinction entre l’usage privé (permis) et l’usage public (interdit). Avec le numérique, cette ancienne distinction n’est plus opérationnelle, dans la mesure où tout ou presque s’effectue “en public” sur Internet. C’est pourquoi le droit d’auteur a besoin d’une nouvelle grande distinction pour conditionner son application.

Et jusqu’à preuve du contraire, c’est la distinction commercial/non-commercial qui est la meilleure candidate pour ce rôle, en favorisant une immense libération des usages, tout en maintenant une sphère économique pour la création.

L’enjeu d’une Culture libre “mainstream”

Au-delà de cet argument essentiel, ce débat rejoint un autre enjeu fondamental, qui est celui de la diffusion des valeurs de la Culture libre. Si l’on reprend l’exemple de Flickr cité ci-dessus, on remarque que la plateforme comporte 240 millions de photographies sous CC… mais sur plus de 6, 5 milliards au total ! Soit un peu plus de 3,6% seulement. C’est certes en soi une masse importante de contenus réutilisables, mais certains y voient néanmoins le signe d’un certain échec des Creative Commons, au moins à devenir “mainstream”.

10 ans après leur création, les CC demeurent cantonnés à une communauté réduite d’utilisateurs. Combien d’entre eux reviendraient en arrière si on leur enlevait la possibilité d’utiliser le NC ? Peut-être pas tous, c’est certain, mais au moins une part importante. Veut-on encore réduire le cercle des utilisateurs, quand celui-ci a déjà du mal à s’étendre ?

Car le point de vue “libriste” pur et dur est encore moins partagé. Il reste nettement ancré autour de la communauté du logiciel libre, avec quelques extensions aux artistes, comme le groupe réunit autour de la licence Art Libre en France, ainsi qu’à la communauté des wikipédiens. Il a en outre la fâcheuse tendance à fonctionner à coup de stigmatisations et d’exclusions, comme ce fut encore le cas récemment avec les critiques qui ont fusé contre Yann Houry, ce professeur qui a été le premier a créé un manuel libre et gratuit sur iPad, mais en choisissant une licence comportant le NC. Immédiatement, le premier réflexe libriste a été de le descendre (horreur, l’iPad !). Pourtant, l’usage de cette licence a paru encore trop subversif à Apple, puisque la firme a demandé le retrait de l’ouvrage de l’Appstore. Preuve s’il en est que l’initiative faisait bien bouger les lignes !

A titre personnel, je rejette catégoriquement cette distinction entre des licences qui seraient libres ou non, parce qu’elles contiendraient une clause NC. Il n’y a pas le “libre” d’un côté et le reste, mais un processus graduel de libération des oeuvres, ou mieux, de mise en partage de la création.

Psychologiquement, le stade essentiel à passer pour mettre en partage son oeuvre n’est pas d’autoriser l’usage commercial. Il est en amont, dans le passage d’une logique où l’interdiction est première (copyright/Tous droits réservés), à une logique où la liberté devient la règle et la restriction l’exception (le principe de base des Creative Commons). C’est ce renversement mental qui fait entrer dans la Culture libre et pas en soi l’abandon du droit patrimonial.

Si les “libristes” souhaitent que les auteurs aillent plus loin, à eux de les convaincre. Mais que le choix soit toujours laissé in fine à l’auteur, ce qui passe par l’acceptation du maintien de la clause non-commerciale.

PS : à titre indicatif, l’auteur de ces lignes précise qu’il utilise constamment pour ses propres créations la licence CC-BY et qu’il n’a donc pas d’intérêt direct dans ce débat. La thèse défendue ici l’est au nom de l’intérêt général.

Photo par Mikeblogs [CC-BY]