Allô, t’as un SSD mais pas RAID 0 ?

mardi 14 mai 2013 à 18:20S’il y a une connerie à faire en informatique, c’est mettre tous ses œufs dans le même panier. Dans ce sens, le RAID 0 représente un moyen efficace pour parvenir à ses fins. Qu’il n’en déplaise aux adorateurs de cette technologie, elle n’est pas sa place dans nos ordinateurs, même pour ceux en quête du moindre Mo/s à grappiller. Reste le cas de figure du gars qui n’a aucune donnée un tant soit peu précieuse et s’en fout si son PC vient à bruler. Pourquoi pas. Dans des datacenters par contre, la vitesse d’accès préoccupe pas mal les administrateurs systèmes, on emploiera par exemple du RAID 10 pour coupler performance et redondance. Mais on va pas commencer à parler serveurs et matériel pro, c’est carrément à deux univers parallèles du hardware destiné aux bas-fonds de la société, nous qui lisons des mails à longueur de journée et jouons à Call Of une fois par mois.

Bref, placer deux HDD en RAID 0 dans l’espoir d’obtenir un gain titanesque au chargement de World of Warcraft, c’est assez utopique. De toute façon je sais même pas pourquoi on parle encore de disque dur alors qu’on ne jure plus que par les SSD. Quoi un SSD suffit pas pour démarrer Windows convenablement ? Deux SSD en RAID 0 tu dis ?

Note : Je raconte des salades ? Personne ne conseille de RAID 0 en SSD vous pensez ? Faites un peu le tour des forums et vous apercevrez ce genre de suggestions plus souvent que vous l’auriez imaginé.

Aspect théorique

Si on savait déjà que monter deux SSD en RAID 0 comportait plus d’inconvénients que d’avantages (mis à part pour le Jacky du coin en manque de reconnaissance et ne sachant pas comment dépenser ses 2000€ de budget en config’), le site tom’s Hardware a réalisé une série de tests, histoire de mettre tout le monde d’accord.

Allons à l’essentiel.

Qu’il soit question de HDD ou de SSD, le RAID 0 apporte un gain très remarquable (on double quasiment le débit) en lecture/écriture séquentielle. C’est à dire lors d’un accès aux données selon une séquence ordonnée. Wikipédia fournit l’exemple d’une bande magnétique, vous avancez ou reculez, pas moyen de sauter à tel emplacement sans parcourir la bobine. Cool mais c’est loin d’être représentatif de la majorité des accès sur nos PC.

Le second type d’accès porte sur la lecture aléatoire, il est largement majoritaire dans notre utilisation de tous les jours. Dans le cas du disque système, le PC accède simultanément à une multitude de données parsemées à plusieurs endroits. La capacité du support à traiter rapidement ces opérations impacte directement les temps d’accès.

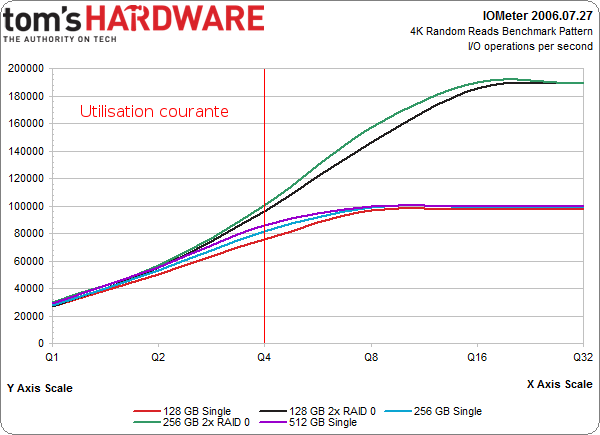

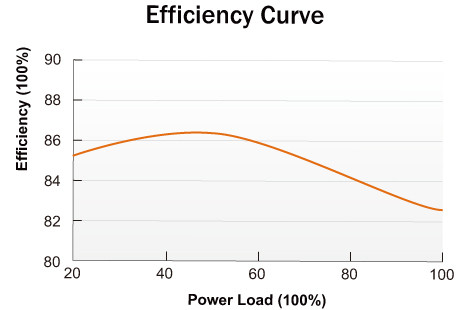

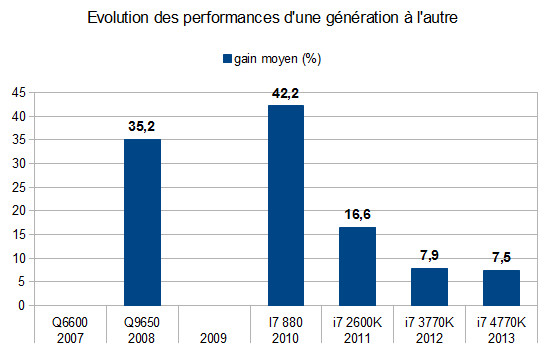

Le graphique suivant démontre la vitesse de traitement des opérations (en ordonnée) en fonction du nombre d’accès simultanés (en abscisse). On commence par 1 accès, 2… puis 32 en même temps. Sachez que lors d’un usage classique, le nombre d’accès simultanés ne dépassera pas qu’exceptionnellement les 4 commandes simultanées, cf la démarcation rouge.

Chaque graphique redirige vers la source originale.

Intéressons nous à la première moitié des courbes, le reste c’est bon pour les marketeux à la recherche de gros pourcentages et score en tous genres à balancer sur leur slide de présentation. Je ne m’attarderais pas plus longtemps sur ce benchmark « théorique », savoir que le RAID 0 apporte 20 000 « I/O operations per second » de plus, ça fournit surtout un ordre d’idée sur le potentiel des SSD et ça confirme qu’on est loin de doubler les perfs’.

Dans la vraie vie

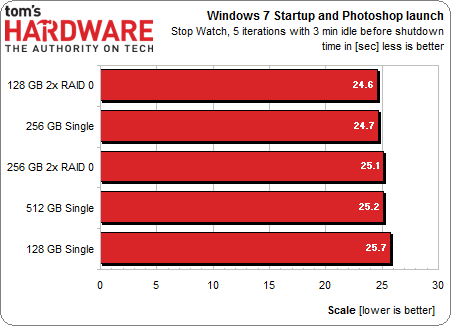

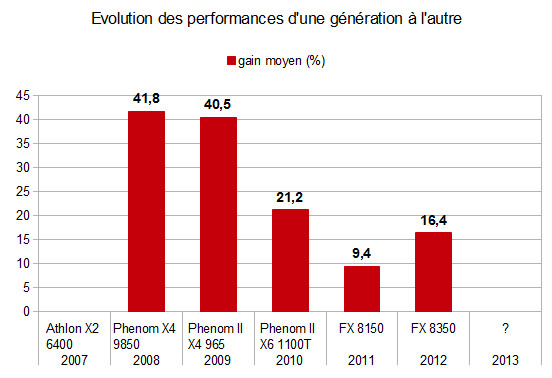

Si on prend l’exemple de la vitesse de lancement de Photoshop comme ci-dessous, c’est tout de suite moins convaincant.

« Woot, j’ai gagné 1.1 seconde sur le lancement de Photoshop en investissant seulement 200€ ! »

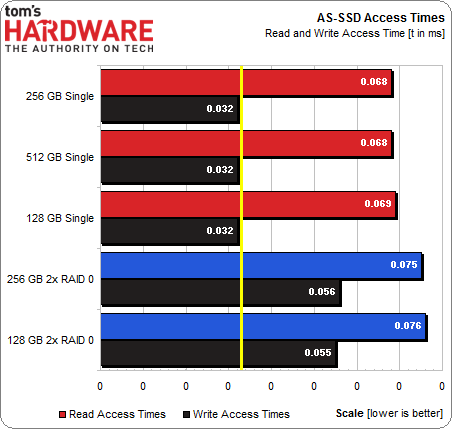

Le plus fun reste le graphique des temps d’accès :

Le RAID 0 affiche une latence plus élevée ! C’est quand même très ennuyeux concernant le principal avantage du SSD.

On va pas tourner autour du pot durant des heures, ces quelques graphiques fournissent les infos qui nous intéresses. Je ne me suis pas attardé sur les débits, à vrai dire déjà quand il s’agit de SSD « seuls », mon avis sur le sujet est plus que mitigé. C’est pratique de pouvoir accéder à ses données à 362Mo/s, mais il faut en avoir les moyens. A quel moment votre PC peut-il atteindre ce débit ? A moins que ne vous copiez des fichiers d’un SSD vers un autre, il n’y a pas de circonstance de ce genre. C’est d’ailleurs pour ça que la différence entre SATA 2 et SATA 3 n’est pas flagrante en pratique. Et ouai, votre SSD se tourne les pouces.

Je le répète une fois de plus ? Rien de mieux qu’un RAID 0 pour gagner 1s au boot de Firefox et doubler le risque d’obtenir des pannes !

Edit : j’ai carrément zappé ce point dans ma conclusion, pourtant c’est le plus important. Si réellement vous souhaitez gagner en performance, la seule et vraie solution c’est d’acheter un SSD de plus grosse capacité. Les temps d’accès sont plus courts et les débits plus élevés. Bien sûr ça reste relatif comme gain. Il vaut mieux investir dans un SSD de 128Go de bonne qualité pour assurer une durée de vie plus longue, plutôt qu’un modèle de 250Go bas de gamme.

Sources :

- tomshardware.fr – SSD : est-il intéressant de les mettre en RAID ?

- hardware.fr – Comparatif SSD 2011